100 其他

项目笔记

- extData: 扩展数据

Total control 手机投屏电脑

## java 各个中间件技术框架

网关:Nginx、Kong、Zuul

缓存:Redis、MemCached、OsCache、EhCache

搜索:ElasticSearch、Solr

熔断:Hystrix、resilience4j

负载均衡:DNS、F5、LVS、Nginx、OpenResty、HAproxy

注册中心:Eureka、Zookeeper、Redis、Etcd、Consul

认证鉴权:JWT

消费队列:RabbitMQ、ZeroMQ、Redis、ActiveMQ、Kafka

系统监控:Grafana、Prometheus、Influxdb、Telegraf、Lepus

文件系统:OSS、NFS、FastDFS、MogileFS

RPC框架: Dubbo、Motan、Thrift、grpc

构建工具:Maven、Gradle

集成部署:Docker、Jenkins、Git、Maven

分布式配置:Disconf、Apollo、Spring Cloud Config、Diamond

压测:LoadRunner、JMeter、AB、webbench

数据库:MySql、Redis、MongoDB、PostgreSQL、Memcache、HBase

网络:专用网络VPC、弹性公网IP、CDN

数据库中间件:DRDS、Mycat、360 Atlas、Cobar (不维护了)

分布式框架:Dubbo、Motan、Spring-Could

分布式任务:XXL-JOB、Elastic-Job、Saturn、Quartz

分布式追踪:Pinpoint、CAT、zipkin

vscode装个插件:live server 可以代码修改后实时更新

https://blog.csdn.net/u012012621/article/details/50998392

打jar https://www.cnblogs.com/qifengshi/p/6036870.html

git 教程 https://www.bilibili.com/video/BV1pW411A7a5?p=58

https://www.bookstack.cn/read/sdky-java-note/3e78ff1a5c3d158d.md

定时器:@Scheduled https://blog.csdn.net/u011374582/article/details/82883620

https://blog.csdn.net/weixin_42753193/article/details/122189782

b站视频下载;https://bilibili.iiilab.com/

接口有HTTP接口、WebService接口、FTP文件传输

gitee 作为图床有个问题,图片大小不能 超过 1M

- 对象存储

- docker部署

技术选型:

- 核心框架:Spring Boot。

- 安全框架:Apache Shiro。

- 模板引擎:Thymeleaf。

- 持久层框架:MyBatis。

- 定时任务:Quartz。

- 数据库连接池:Druid。

- 工具类:Fastjson。

翻墙:https://www.zionladdero.com/

待整理:https://blog.csdn.net/qq_33683097/article/details/81230111 ssm maven 工程目录以及环境搭建(对配置文件的介绍)

整理代表:ydxjApply 巡检保人事申请

接口开发:https://blog.csdn.net/diyangxia/article/details/64122387

https://oss.console.aliyun.com/bucket/oss-cn-shanghai/lishihuan/object?path=20210408%2F

https://blog.csdn.net/vivivi_lau/article/details/106501715

git: https://git-scm.com/book/zh/v2

图形化工具:Source Tree,[TortoiseGit](# https://www.cnblogs.com/xiuxingzhe/p/9312929.html)

https://www.cnblogs.com/tugenhua0707/p/4050072.html

js 实现 复制图片到剪切板 https://blog.csdn.net/MICHAELKING1/article/details/89642497

js 模板:https://blog.csdn.net/qq_42943107/article/details/91045524

css 动画;https://zh.javascript.info/css-animations#guan-jian-zhen-dong-hua-keyframes

css 实现 图文切换:https://www.cnblogs.com/cs-whut/p/13463928.html (C:\Users\lishihuan\Desktop\html动画-待整理\CSS动画实例:图文切换.html)

layer 弹窗层 https://blog.csdn.net/qq_37335220/article/details/82024066

图片 都放到一起,通过定位来 显示 当中的 具体 图片,例如ztree 图标 (用到属性 background-position)

Collections3.extractToString 对 集合的处理

使用 Fiddler 实现本地代码替换远程代码 https://zhangzw.com/posts/20190501.html

idea 设置svn代码忽略:https://blog.csdn.net/idongit/article/details/103079171

https://tool.lu/tinyimage/ 在线压缩图片

java 待整理: ControllerAdvice 注解

测试图片:https://gitee.com/mylishihuan/image/raw/master/img/20201115092508.jpg

引入 jQuery 库

<script src="http://code.jquery.com/jquery-1.11.3.min.js"></script> <script src="http://www.jq22.com/jquery/1.11.1/jquery.min.js"></script>

待整理 盒子模型:https://www.cnblogs.com/hellocd/p/10443237.html

待整理: js 闭包 https://blog.csdn.net/weixin_39214481/article/details/86164785

待整理-java 导出word:https://www.jianshu.com/p/de58ab550157

https://blog.csdn.net/xm393392625/article/details/88795547 插入图片

var data = eval('('+evt.data+')');

JSON.parse(itemStr);

跨域:https://blog.csdn.net/qq_30546099/article/details/71404574

不同域名之间共享localStorage/sessionStorage https://www.jianshu.com/p/8c4cee29d532 (解决跨域场景)

netty websocket实现心跳和断线重连

https://www.cnblogs.com/chaizezhao/articles/5291608.html

app开发;https://blog.csdn.net/lucy_100/article/details/49820393

待整理,CPMS 组织树 (TreeBean)

整理 图片放大器:<div ng-include="'modules/sys/picGiger.html'"></div> 如何实现 作为公共 模块的

待整理:坐标转换(java,js) 坐标获取位置信息

Notepad++ 临时备份文件路径: C:\Users\lishihuan\AppData\Roaming\Notepad++\backup\

全景图 photo-sphere-viewer : https://www.jianshu.com/p/78208c73a896https://photo-sphere-viewer.js.org/ 2D:https://blog.csdn.net/haiwei_lian/article/details/109012683

J2Cache缓存:https://gitee.com/ld/J2Cache

快捷键:

https://blog.csdn.net/ademoa/article/details/80091939

Idea:

ctrl+shift+x 转为大写

ctrl+shift+y 转为小写

sql 美化器:ctrl+alt+

Ctrl+alt+v 补全等号左侧

Alt+Ctrl+T 快速 tyr/catch (选中代码后也可以使用快捷键,Alt+Shift+Z 快速tyr/catch)

new XXX(); @ + L 自动生成new的新对象

Ctrl +shift+ o 批量引出jar包和删除多余jar包

for 循环 补全 https://blog.csdn.net/weixin_41637749/article/details/83784570 https://blog.csdn.net/mingjie1212/article/details/51143444

收起展开所有方法的快捷键( Ctrl+Shift+'/'(小键盘的‘/‘) Ctrl+alt+= 递归展开当前方法 )

- 全部展开、折叠:Ctrl+Shift+”+/-”,

- 展开、折叠当前方法:Ctrl + " +/- "

- 小写转换大写 Ctrl + shift + U

- 大写转换小写Ctrl + U

- 复制当前行 Ctrl + D

- 删除当前行 Ctrl +L (相当于剪切 + 删除行,并不是存粹的删除行)

ctrl+q 可以查看方法具体在哪个包里面,或是jar包

- ctrl+alt+o 去掉没有引用的import

- ctrl+alt+B 查看接口被哪些类实现

- ctrl+shift+alt+u 查看类的继承关系

- ctrl+alt+u 查看类的继承关系

- ctrl+shift+u 代码中大小写切换

- ctrl+O 选择父类方法去重写,这里没有继承直接显示继承自Object类的方法

MyEclipse :

- Alt+Shift+L 代码等号右边自动补全

- 收起展开所有方法的快捷键

- 收缩所有方法:Ctrl+Shift+'/'(小键盘的‘/‘)

- 展开所有方法:Ctrl+Shift+'*'(小键盘的)

输入法英文间距太大 (全角和半角) shift+空格

常用次:扁平化,存量,增量

坐标系

公司:

谷歌地图:31.9344120986,117.2649120808 ----> 和 腾讯和高德坐标偏移很小

百度地图:31.9405040000,117.2714210000

腾讯高德:31.9344119085,117.2649256012

图吧地图:31.9378224285,117.2620342812

谷歌地球:31.9364424285,117.2594242812 ---> 现在市面上 GPS都是用这个的

北纬N31°56′11.19″ 东经E117°15′33.93″

坐标系说明

WGS84坐标系 地球坐标系,国际通用坐标系 ---GPS

GCJ02坐标系 火星坐标系,WGS84坐标系加密后的坐标系;Google国内地图、高德、QQ地图、腾讯地图 使用

BD09坐标系 百度坐标系,GCJ02坐标系加密后的坐标系

注:

谷歌地图API,高德地图API,腾讯地图API上取到的,都是GCJ-02坐标,他们三家都是通用的

百度:BD-09坐标

谷歌地球,google earth上取到的,是GPS坐标。而且是度分秒形式的经纬度坐标。在国内不允许使用。必须转换为GCJ-02坐标

数据库

数据库连接失败,navicat可以连接上,但是java程序无法连接 useSSL=false

11 oracle

plsql 中 ctrl+e 查看 历史执行的语句

shu据库:https://192.168.99.19:1158/em

11.1

命令运行 : sqlplus /nolog

给system赋权 :grant sysdba to system;

sql文件导入导致plsql 等工具卡死,无法执行解决:

1.cmd-->输入: conn sys/as sysdba

2.输入密码 lishihuan

3. sql>@'D:\aa.sql'; 执行后导入sql文件

oracle em 主机身份证明 输入的用户名和密码是 电脑端的,比如我的是 wangyilishihuna@163.com e9q......

cmd 执行 sql 命令

sqlplus /nolog

conn /as sysdba

11.1oracle 一些常用 语句

数据库创建一个用户

/*(命令行运行: sqlplus /nolog 在SQL>提示符后面运行: conn /as sysdba 命令横提示Connected说明连接成功;)*/

--1.查询用户 (检查用户对象,导库的时候可以用来检测,目标用户是否存在)

select * from dba_users;

--2.查询表控件本地存储位置

select name from v$datafile;

--3.创建表空间

create tablespace sdt_tyxxpt datafile 'D:\ORACLE\ORADATA\ORCL\sdt_tyxxpt.dbf' size 50m autoextend on next 50m maxsize 20480m extent management local;

--说明:(create tablespace 表空间名称 datafile '数据文件的路径' size 大小 autoextend on ; (autoextend 自增长)命令行输入)

--4.创建用户: 创建用户语法:create user 用户名 identified by 密码 default tablespace 用户默认使用哪一个表空间;

create user sdt_tyxxpt identified by sdt_tyxxpt default tablespace sdt_tyxxpt temporary tablespace temp;

--5.给用户授予权限

grant connect,resource,dba to sdt_tyxxpt;

--6.删除 (https://blog.csdn.net/dongyuxu342719/article/details/81530942)

--删除用户

drop user 用户名称 cascade;

--删除表空间(同时也会删除本地存储 的dmp文件)

drop tablespace 表空间名称 including contents and datafiles cascade constraint;

-- 7.修改用户密码

alter user SDT_XJB identified by SDT_XJB;

--8.数据库em

https://localhost:1158/em;

删除用户失败,提示 ORA-01940 用户被使用在,所以需要先杀死进程

select username,sid,serial#,paddr from v$session where username='INVOICE'; alter system kill session '62,22594';

修改用户密码

alter user 用户名 identified by 新密码;

查询每个表的 数据量

select u.TABLE_NAME,u.NUM_ROWS from user_tables u order by u.NUM_ROWS desc

查看ORACLE表空间大小及所剩空间大小 (单位MB)

select a.tablespace_name,

a.bytes / 1024 / 1024 "Sum MB",

(a.bytes - b.bytes) / 1024 / 1024 "used MB",

b.bytes / 1024 / 1024 "free MB",

round(((a.bytes - b.bytes) / a.bytes) * 100, 2) "percent_used"

from (select tablespace_name, sum(bytes) bytes

from dba_data_files

group by tablespace_name) a,

(select tablespace_name, sum(bytes) bytes, max(bytes) largest

from dba_free_space

group by tablespace_name) b

where a.tablespace_name = b.tablespace_name

order by ((a.bytes - b.bytes) / a.bytes) desc;

SELECT UPPER(F.TABLESPACE_NAME) "表空间名",

D.TOT_GROOTTE_MB "表空间大小(M)",

D.TOT_GROOTTE_MB - F.TOTAL_BYTES "已使用空间(M)",

TO_CHAR(ROUND((D.TOT_GROOTTE_MB - F.TOTAL_BYTES) / D.TOT_GROOTTE_MB * 100, 2),'990.99') "使用比",

F.TOTAL_BYTES "空闲空间(M)",

F.MAX_BYTES "最大块(M)"

FROM (SELECT TABLESPACE_NAME,

ROUND(SUM(BYTES) / (1024 * 1024), 2) TOTAL_BYTES,

ROUND(MAX(BYTES) / (1024 * 1024), 2) MAX_BYTES

FROM SYS.DBA_FREE_SPACE

GROUP BY TABLESPACE_NAME) F,

(SELECT DD.TABLESPACE_NAME,

ROUND(SUM(DD.BYTES) / (1024 * 1024), 2) TOT_GROOTTE_MB

FROM SYS.DBA_DATA_FILES DD

GROUP BY DD.TABLESPACE_NAME) D

WHERE D.TABLESPACE_NAME = F.TABLESPACE_NAME

ORDER BY 4 DESC;

查询表空间

SELECT owner,t.table_name,

num_rows, --记录行数

s.bytes / 1024 / 1024 AS size_mb

FROM all_tables t

JOIN user_segments s ON t.table_name = s.segment_name

WHERE s.segment_type = 'TABLE'

AND t.owner = 'SDT_ZHST_2024' -- 目标用户

ORDER BY size_mb DESC;

查询大表,并且释放表空间

- 最优的是 通过

DROP TABLE table_name;CREATE TABLE table_name (...);-- 重新创建表- 通过 delete 删除后,不会自动释放空间,需要 可以 使用

SHRINK SPACE命令

-- 启用行移动: 使用以下命令来启用表的行移动:

ALTER TABLE SYS_LOG ENABLE ROW MOVEMENT;

-- 行空间压缩操作: 启用行移动后,你可以执行 SHRINK SPACE 或 MOVE 操作来释放空间

ALTER TABLE SYS_LOG SHRINK SPACE;

ALTER TABLE SYS_LOG MOVE;

-- 禁用行移动(可选): 如果你完成了所需的操作,并且希望禁用行移动,可以执行以下命令

ALTER TABLE SYS_LOG DISABLE ROW MOVEMENT;

查询用户下的所有表

select t.* from user_tables t;

select * from all_tab_comments;--查询所有用户的表,视图等。

select * from user_tab_comments;--查询本用户的表,视图等。

select * from all_col_comments;--查询所有用户的表的列名和注释。

select * from user_col_comments;--查询本用户的表的列名和注释。

select * from all_tab_columns;--查询所有用户的表的列名等信息。

select * from user_tab_columns;--查询本用户的表的列名等信息。

/*

ORACLE下有三个视图

DBA_TABLES 拥有DBA角色的用户可以查看系统中的所有表

USER_TABLES 登录数据库的当前用户拥有的所有表

ALL_TABLES 登录数据库的当前用户有权限查看的所有表

*/

查询空表

select * from user_tables where num_rows=0;

select username,default_tablespace from user_users;-- 查询当前用户下的表空间

select name from v$datafile;-- 查询表空间的位置

SELECT FILE_NAME,TABLESPACE_NAME,AUTOEXTENSIBLE FROM dba_data_files; -- 查看表空间是否自增长

修改表空间

-- 如果是 迁移表,针对需要 修改表空间的场景,需要 分2步,1.修改表的 表空间 2.重建 索引 的 表空间

---- 1.讲表 ACT_RU_JOB 的表空间修改为 SDT_XJB

alter table ACT_RU_JOB move tablespace SDT_XJB;

---- 2. 重建 索引

select 'alter index '||index_name||' rebuild online;' from user_indexes

where status <> 'VALID' and index_name not like'%$$' or tablespace_name ='SDT_IMOA';;

----- 本质执行 alter index 索引名称 rebuild online; 重建

-- 查询索引(用于检查是否有些 重构 索引 但是没有 讲表空间修改 好)

select tablespace_name,index_name,t.table_name,t.status from SYS.USER_INDEXES t;--(USER_INDEXES 查询索引信息的视图)

--批量修改(找到 索引 表空间为 SDT_IMOA 的所有索引 修改语句,将其 修改为 CPMS)

select 'alter index '||index_name||' rebuild tablespace CPMS;' from user_indexes where tablespace_name ='SDT_IMOA';

--alter index 索引名称 rebuild online; --重建

--alter index 索引名称 rebuild tablespace 表空间; --修改表空间

增加表空间

-- 1. 创建表空间

create tablespace SDT_XJB datafile 'D:\app\Administrator\oradata\orcl\SDT_XJB02.DBF' size 1024m autoextend on next 50m maxsize 20480m extent management local;

-- 2.增加表空间文件-针对表空间不够

alter tablespace SDT_XJB add datafile 'D:\app\Administrator\oradata\orcl\SDT_XJB02.DBF' size 30720M AUTOEXTEND on next 100m;

拼接语句查询出所有表要迁入表空间的语句,这样可以批量查询出来,修改方便。

select 'alter table '|| table_name ||' move tablespace 要迁入的表空间;' from dba_tables t where t.owner='要迁出的表归属用户名';

查询出指定表空间下的表:

select tablespace_name,table_name from user_tables WHERE tablespace_name='表空间名称';

查询出单一表对应的表空间:

select tablespace_name,table_name from user_tables where table_name='表名';

复制表,迁移表

注: 这样用于 迁移表 比 exp和imp 导出方便,如果两个数据库不在一起,可以通过建立 dblink

-- 迁移 同数据库,不同 用户下的 接地线表,即 讲 SDT_IMOA用户下的巡检保表 迁移到 巡检保下

select

'create table '|| table_name ||' as select * from SDT_IMOA.'|| table_name ||';'

from user_tables where table_name like 'JDX_%';

获取 DDL 语句

SELECT DBMS_METADATA.GET_DDL('TABLE',u.table_name) FROM USER_TABLES u;

SELECT DBMS_METADATA.GET_DDL('INDEX',u.index_name) FROM USER_INDEXES u;

查询每个表数量

select t.table_name,t.num_rows from user_tables t;

主键、唯一性约束 、联合主键

对于除了主键还需要 其他字段做唯一性约束,(例如部门下管的行政区域,那么中间表需要 部门和行政区域合再一起做唯一性约束)

alter table zcz add constraints zcz_pk primary key (id); -- 主键

alter table zcz add constraints zcz_name_age primary key (name,age);--联合主键

--创建联合约束(下面该条sql的作用是name和age不能同时相等)

CREATE UNIQUE INDEX zcz_name_age ON zcz(NVL2(name,age,NULL),NVL2(name,name,NULL));

-- 创建unique唯一约束(不能存在 name+age相同的数据)

alter table table_name add constraint name_age_unique unique(name,age));

-- 给表添加 主键和联合约束

alter table BAS_C_LINE_RELEVANCE

add constraints PK_BAS_C_LINE_RELEVANCE primary key (id)

add constraint ID_PID_UNIQUE unique(LINE_PID,LINE_ID);

查询库中的表名和表中记录数

SELECT T.TABLE_NAME, T.NUM_ROWS FROM USER_TABLES T;

表数据被删除,但是空间没被释放

truncate table YDXJ_DW_DWJL_2018_08 DROP STORAGE;

alter TABLE YDXJ_DW_DWJL_2018_08 deallocate unused keep 1k;

导入时报:ora-01659 表空间自增长的原因

select name from v$datafile;

alter database datafile 'D:\APP\LISHIHUAN\ORADATA\ORCL\SDT_XJB.DBF' autoextend on;

#### 创建表:

create table 表名 (

字段名1 字段类型 默认值 是否为空 ,

字段名2 字段类型 默认值 是否为空,

字段名3 字段类型 默认值 是否为空,

......

);

demo 创建一个user表:

create table user (

id number(6) primary key, ---主键

name varchar(50) not null, ---姓名 不为null

sex varchar2(6) default '男' check ( sex in ('男','女')) ---性别 默认'男'

);

create table 表名 ( 字段名1 字段类型 默认值 是否为空 , 字段名2 字段类型 默认值 是否为空, 字段名3 字段类型 默认值 是否为空, ...... ); demo 创建一个user表:

修改表名:

rename 旧表名 to 新表名;

rename user to newuser;

删除表

delete from 表名;

delete删除数据是一条一条的删除数据,后面可以添加where条件,不删除表结构。注意:如果表中有identity产生的自增id列,delete from后仍然从上次的数开始增加。

truncate table 表名;

truncate是一次性删掉所有数据,不删除表结构。注意:如果表中有identity产生的自增id列,truncate后,会恢复初始值。

drop table 表名;

drop删除所有数据,会删除表结构。

修改表

- 添加新字段:

alter table 表名 add(字段名 字段类型 默认值 是否为空);

alter table user add(age number(6));

alter table user add (course varchar2(30) default '空' not null);

## 添加备注

comment on column SYS_PUSH_CONTENT.meta_info is '存储非格式化数据(用于针对不同消息展示的不同消息内容的情况)';

- 修改字段:

alter table 表名 modify (字段名 字段类型 默认值 是否为空);

alter table user modify((age number(8));

- 修改字段名:

alter table 表名 rename column 列名 to 新列名;

alter table user rename column course to newcourse;

- 删除字段:

--1、从表中随机取记录

select * from (select * from staff order by dbms_random.random) where rownum < 4 --表示从STAFF表中随机取3条记录

--2、产生随机数

SELECT DBMS_RANDOM.RANDOM FROM DUAL; --产生一个任意大小的随机数

SELECT ABS(MOD(DBMS_RANDOM.RANDOM,100)) FROM DUAL; --产生一个100以内的随机数

SELECT TRUNC(100+900*dbms_random.value) FROM dual; --产生一个100~1000之间的随机数

SELECT dbms_random.value FROM dual; --产生一个0~1之间的随机数

SELECT dbms_random.value(10,20) FROM dual; --产生一个10~20之间的随机数

SELECT dbms_random.normal FROM dual; --NORMAL函数返回服从正态分布的一组数。此正态分布标准偏差为1,期望值为0。这个函数返回的数值中有68%是介于-1与+1之间,95%介于-2与+2之间,99%介于-3与+3之间。

--3、产生随机字符串

select dbms_random.string('P',20) from dual; --第一个参数 P 表示 printable,即字符串由任意可打印字符构成 第二个参数表示返回字符串长度

--4、ceil( n )函数是返回大于或等于n的最小整数。

/*

DBMS_RANDOM.VALUE()是随机产生( 0,1 )之间的数。要产生两位的随机数,可以DBMS_RANDOM.VALUE()*100,这样产生( 0,100 )的随机数,当产生( 0,10)之间的数时,只要加上10就可以保证产生的数都是两位了。

*/

--ORACLE的PL/SQL提供了生成随机数和随机字符串的多种方式,罗列如下:

--1、小数( 0 ~ 1)

select dbms_random.value from dual;

--2、指定范围内的小数 ( 0 ~ 100 )

select dbms_random.value(0,100) from dual

--3、指定范围内的整数 ( 0 ~ 100 )

select trunc(dbms_random.value(0,100)) from dual

--4、长度为20的随机数字串

select substr(cast(dbms_random.value as varchar2(38)),3,20) from dual

--5、正态分布的随机数

select dbms_random.normal from dual

--6、随机字符串

select dbms_random.string(opt, length) from dual

--opt可取值如下: 'u','U' : 大写字母 'l','L' : 小写字母 'a','A' : 大、小写字母 'x','X' : 数字、大写字母 'p','P' : 可打印字符

--7、随机日期

select to_date(2454084+TRUNC(DBMS_RANDOM.VALUE(0,365)),'J') from dual

通过下面的语句获得指定日期的基数

select to_char(sysdate,'J') from dual

--8、生成GUID

select sys_guid() from dual

--生成带分隔符(-)的GUID的自定义函数

create or replace function my_guid return varchar2 is guid varchar(36); temp varchar(32); begin temp:=sys_guid(); guid:= substr(temp,1,8) || '-' ||substr(temp,9,4) || '-' ||substr(temp,13,4)|| '-' ||substr(temp,17,4)|| '-' ||substr(temp,21,12); return guid; end;

修改表空间

已 表空间为 SDT_YJWZ_TEMP 这个为例: 将 表空间不是 SDT_YJWZ_TEMP 改为 SDT_YJWZ_TEMP

- 单个表修改表空间

ALTER TABLE SDT_YJWZ_TEMP.表名

MOVE TABLESPACE SDT_YJWZ_TEMP;

-- 生成索引重建 SQL

ALTER INDEX SDT_YJWZ_TEMP.索引名

REBUILD TABLESPACE SDT_YJWZ_TEMP;

- 批量修改

SELECT

'ALTER TABLE ' || owner || '.' || table_name ||

' MOVE TABLESPACE SDT_YJWZ_TEMP;'

FROM dba_tables

WHERE owner = 'SDT_YJWZ_TEMP'

AND tablespace_name <> 'SDT_YJWZ_TEMP';

-- 生成索引重建 SQL

SELECT

'ALTER INDEX ' || owner || '.' || index_name ||

' REBUILD TABLESPACE SDT_YJWZ_TEMP;'

FROM dba_indexes

WHERE owner = 'SDT_YJWZ_TEMP'

AND tablespace_name <> 'SDT_YJWZ_TEMP';

LOB 字段怎么办?(很多人踩坑)

如果表里有

CLOB / BLOB,只 MOVE 表是不够的

-- 查 LOB

SELECT table_name, column_name, tablespace_name

FROM dba_lobs

WHERE owner='SDT_YJWZ_TEMP'

AND tablespace_name <> 'SDT_YJWZ_TEMP';

-- 移动 LOB

ALTER TABLE SDT_YJWZ_TEMP.表名

MOVE LOB(列名) STORE AS (TABLESPACE SDT_YJWZ_TEMP);

11.2 数据库导入,导出

- 导出/导入的时候考虑到用户下的表可能存在多个表空间,导致数据迁移存在异常,所以可以先查询表所涉及到的表空间,然后导入的时候合并一下

SELECT table_name, tablespace_name

FROM all_tables

WHERE owner = '用户名';

exp 导出 imp 导入

遇到密码特殊字符 使用3个双引号

exp sdt_xjb/"""Ahsbd@2021yjfgs"""@172.16.10.247:1521/yjdb file=D:\temp\ydxj_dundian_20211118.dmp tables=(xjb_dundian_%)

exp 导出 imp 导入 (EXP和IMP是客户端工具程序,它们既可以在客户端使用,也可以在服务端使用。EXP不会导出空表,可能会对存储过程有影响)

1.导出:exp sdt_imoa/sdt_imoa@192.168.10.228/yjdb2 file=d:\sdt_imoa_20180831.dmp tables=(ydxj_dundian_%) rows=n

说明: 1.sdt_imoa/sdt_imoa 是用户名和密码

2.@192.168.10.228/yjdb2 对应连接数据库时的路径192.168.10.229:1521/yjdb

3.tables=(BAS_TOWER_%,BAS_FROMPART_TYPE,BAS_TYPEFROM_REF) 指定导出表,支持模糊匹配

4.rows=n 表示只要表结构,不要数据

案例:将数据库中system用户与sys用户的表导出

exp system/manager@TEST file=d:\daochu.dmp owner=(system,sys)

案例:将数据库中的表table1中的字段filed1以"00"打头的数据导出

exp system/manager@TEST file=d:\daochu.dmp tables=(table1) query=\" where filed1 like '00%'\"

2.导入: imp sdt_tyxxpt/sdt_tyxxpt@61.191.56.150:1521/xjb file=f:\sdt_imoa2018-08-31.dmp full=y data_only=y log=E:\20191127.log ;

说明:1.rows=n 只导表结构

2.data_only=y 只导数据

3.ignore=y只导入数据,不导入表结构(没有的表,创建并倒入数据,如果已经有的表,忽略创建的,但不忽略倒入)

4. 日志输出 log

案例: 将d:\daochu.dmp中的表table1 导入

imp system/manager@TEST file=d:\daochu.dmp tables=(table1)

如果导入的表空间不同,导入数据会报错,那么可以先只导入表结构,然后通过imp 导入表数据

3.指定表空间导入,没测试过(针对全数据库导出,先需要导出特定的用户,fromuser=用户)

imp CPMS_INVO/CPMS_INVO@36.7.176.72:11521/xjb fromuser=invoice touser=CPMS_INVO file=E:\invo_20191127.dmp log=E:\20191127.log

fromuser指定dmp文件中要导出的用户,touser 准备导入表的 数据用户

存在问题

EXP不会导出空表,可能会对存储过程有影响 https://www.2cto.com/database/201703/615378.htmlhttps://blog.csdn.net/whxlovexue/article/details/82378389

可能会出现提示表空间不存在,也即是讲当前创建的用户和exp导出的不一致,只能新增一个表空间来解决,获取用

EXPDP和IMPDP可以指定

--1.在建好数据库后执行如下脚本:

alter system set deferred_segment_creation=false;

--2:批量执行空表更新语句

--A: 查询当前用户下的所有记录数为空的表

select TABLE_NAME from user_tables t where t.NUM_ROWS = 0 or t.NUM_ROWS is null;

--B:生成修改语句,将SEGMENT_CREATED 修改为YES

select 'alter table '||table_name||' allocate extent;' from user_tables t where t.NUM_ROWS = 0 or t.NUM_ROWS is null;

--参考网址:https://blog.csdn.net/whxlovexue/article/details/82378389

imp/impdp 和 EXPDP和IMPDP时应该注意的事项:

- EXP和IMP是客户端工具程序,它们既可以在客户端使用,也可以在服务端使用。

- EXPDP和IMPDP是服务端的工具程序,他们只能在ORACLE服务端使用,不能在客户端使用。

- IMP只适用于EXP导出的文件,不适用于EXPDP导出文件;IMPDP只适用于EXPDP导出的文件,而不适用于EXP导出文件。

数据泵:expdp/impdp导出/导入数据

数据库恢复(导入):需要将之前的数据库清除,因为不能覆盖恢复,所以会导出失败

数据泵:expdp/impdp导出/导入数据

https://www.cnblogs.com/wanghongyun/p/6307652.html

使用impdp命令,需要在oracle数据库服务器操作:

1.使用sqlplus或者Oracle客户端(PL/SQL) 链接到相应的Oracle数据库实例(进行下面第一,第二两步骤的操作)

一、创建逻辑目录,该命令不会在操作系统创建真正的目录,最好以system等管理员创建。

创建:create directory dpdata1 as 'd:\temp';

修改:create or replace directory dpdata1 as 'E:\temp';

删除:drop directory dpdata1;

(查看服务器上若没有存在d:\temp目录,则手动新建,把dmp备份文件放到d:\temp目录下面)

二、查看管理理员目录(同时查看操作系统是否存在,因为Oracle并不关心该目录是否存在,如果不存在,则出错)

select * from dba_directories;

2.导入数据库(桌面下执行cmd--然后命令)

--expdp导出数据

expdp CCENSE/CCENSE@OracleDB directory = "dpdata1" dumpfile ="oracleExpdp.dmp" logfile = oracleExpdp20161103.log

expdp CCENSE/CCENSE@OracleDB directory = "dpdata1" dumpfile ="oracleExpdp.dmp" logfile = oracleExpdp20161103.log schemas=SDT_IMOA tablespaces=YOUR_TABLESPACE_NAME

/*

* schemas=SDT_IMOA 指定导出用户

* tablespaces=YOUR_TABLESPACE_NAME 指定导出表空间

*/

--impdp导入数据

impdp CCENSE/CCENSE@OracleDB directory="dpdata1" dumpfile="oracleExpdp.dmp" logfile = oracleImpdp20161103.log FULL=y;

/* 说明:CCENSE/CCENSE@OracleDB --->用户名/密码@数据库实例

directory="在步骤一中创建的逻辑目录"

dumpfile="需要导入/导出的dmp文件全称"

logfile="日志文件"

tables=xxx,xxx 指定导出表

FULL=y;

针对密码存在特殊字符的 expdp sdt_imoa/"""sdt_zhst@Ahsbd"""@xxx/yjdb

注意: 如果 目标用户和导出的用户不一致,一定要 通过REMAP_SCHEMA去指定,如: REMAP_SCHEMA=CPMS:CPMS_0309 如果不指定,则导入的数据会自动创建CPMS_0309 而不是希望的 CPMS用户中

*/

impdp CPMS_0309/CPMS_0309@127.0.0.1:1521/orcl directory = dpdata1 dumpfile =CPMS_0309.dmp logfile = CPMS_0309.log REMAP_SCHEMA=CPMS:CPMS_0309 remap_tablespace=CPMS:CPMS_0309

-- 讲CPMS正式数据库的表导入到 CPMS_0309用户下,impdp可以指定 需要导入的表空间和用户

REMAP_SCHEMA=CPMS:CPMS_0309 表示 由原来的 CPMS用户导入到CPMS_0309用户下, remap_tablespace=CPMS:CPMS_0309表示 由原来的CPMS表空间导入到CPMS_0309表空间下 可以多个

但是 可能存在 告警CPMS.xxx 表存在的问题,可以添加 TABLE_EXISTS_ACTION=REPLACE 【用了REMAP_SCHEMA=CPMS:CPMS_0309 这个不应该会出现这个告警】

impdp ... REMAP_SCHEMA=CPMS:CPMS_0309 remap_tablespace=CPMS:CPMS_0309 TABLE_EXISTS_ACTION=REPLACE

--其他SQL

--表空间[10G]和临时表空间[1G]

/*表空间*/

SELECT t.tablespace_name, round(SUM(bytes / (1024 * 1024)), 0) ts_size

FROM dba_tablespaces t, dba_data_files d

WHERE t.tablespace_name = d.tablespace_name

GROUP BY t.tablespace_name;

/*临时表空间*/

select tablespace_name,file_name,bytes/1024/1024 file_size,autoextensible from dba_temp_files;

-- 查看端口是否被占用

netstat -aon|findstr "1522"

-- 查看监听状态,启动监听,关闭监听

lsnrctl status LISTENER2

lsnrctl start LISTENER2

lsnrctl stop LISTENER2

--访问地址

linux sqlplus ccense/ccense@//localhost:1521/OracleDB;

win sqlplus ccense/ccense@IP:1521/OracleDB;

expdp流程

一、新建逻辑目录

最好以system等管理员创建逻辑目录,Oracle不会自动创建实际的物理目录“D:\oracleData”(务必手动创建此目录),仅仅是进行定义逻辑路径dump_dir;###

忘记sys用户密码的可以去下如何修改sys用户密码;建议使用pl、navicat等oracle操作工具来操作;

登陆后sql执行:create directory mydata as '逻辑目录路径'; 例如:

create directory mydata as '/data/oracle/oradata/mydata';

二、查看逻辑目录是否创建成功

执行sql:

select * from dba_directories

三、用expdp导出数据 用法及解释:

expdp 用户名/密码@ip地址/实例 [属性]

ip地址不写默认就是本地 userid=test/test --导出的用户,本地用户!! directory=dmpfile --导出的逻辑目录,一定要在oracle中创建完成的,并且给用户授权读写权限 dumpfile=xx.dmp --导出的数据文件的名称,如果想在指定的位置的话可以写成dumpfile=/home/oracle/userxx.dmp logfile=xx.log --日志文件,如果不写这个参数的话默认名称就是export.log,可以在本地的文件夹中找到 schemas=userxx --使用dblink导出的用户不是本地的用户,需要加上schema来确定导出的用户,类似于exp中的owner,但还有一定的区别 EXCLUDE=TABLE:"IN('T1','T2','T3')" --exclude 可以指定不导出的东西,table,index等,后面加上不想导出的表名 network_link=db_local --这个参数是使用的dblink来远程导出,需要指定dblink的名称

列出一些场景:

--1)导出用户及其对象

expdp scott/tiger@orcl schemas=scott dumpfile=expdp.dmp directory=dump_dir logfile=expdp.log;

--2)导出指定表

expdp scott/tiger@orcl tables=emp,dept dumpfile=expdp.dmp directory=dump_dir logfile=expdp.log;

--3)按查询条件导

expdp scott/tiger@orcl directory=dump_dir dumpfile=expdp.dmp tables=empquery='where deptno=20' logfile=expdp.log;

--4)按表空间导

expdp system/manager@orcl directory=dump_dir dumpfile=tablespace.dmp tablespaces=temp,example logfile=expdp.log;

--5)导整个数据库

expdp scott/123@127.0.0.1/orcl directory=dump_dir dumpfile=ly.dmp full=y logfile=expdp.log;

一般用的都是导出整个数据库

--包含所有用户的表、视图、索引等

expdp JCPT/123@127.0.0.1/orcl directory=mydata dumpfile=ly.dmp full=y logfile=expdp.log;

--指定用户的表、视图、索引等

expdp JCPT/123@127.0.0.1/orcl directory=mydata schemas=jcpt dumpfile=ly.dmp logfile=expdp.log;--

导出完成后:逻辑目录生成了一个 dmp文件;

IMPDP数据导入

在正式导入数据前,要先确保要导入的用户已存在,如果没有存在,请先用下述命令进行新建用户

流程:

一、创建表空间

使用system登录oracle,执行sql

格式: create tablespace 表间名 datafile '数据文件名' size 表空间大小

create tablespace data_test datafile 'e:\oracle\oradata\test\test.dbf' size 2000M;

-- 数据文件名 包含全路径, 表空间大小 2000M 表是 2000兆

二、创建用户并授权

格式: create user 用户名 identified by 密码 default tablespace 表空间表;

create user study identified by study default tablespace data_test;

-- 我们创建一个用户名为 study,密码为 study, 表空间为 madate-这是在上一步建好的

授权给 用户 study ,执行sql

#给用户逻辑目录读写权限

sql>grant read,write on directory mydata to study;

#给用户表空间权限

sql>grant dba,resource,unlimited tablespace to study;

三、impdp导入

命令在cmd或者控制台输入,不是sql语句

写法:

impdp 用户名/密码@ip地址/实例 [属性]

ip地址不写默认就是本地

注释:

-- 1)导入用户(从用户scott导入到用户scott)

impdp scott/tiger@orcl directory=dump_dir dumpfile=expdp.dmp schemas=scott logfile=impdp.log;

-- 2)导入表(从scott用户中把表dept和emp导入到system用户中)

impdp system/manager@orcl directory=dump_dir dumpfile=expdp.dmp tables=scott.dept,scott.emp remap_schema=scott:system logfile=impdp.log table_exists_action=replace (表空间已存在则替换);

-- 3)导入表空间

impdp system/manager@orcl directory=dump_dir dumpfile=tablespace.dmp tablespaces=example logfile=impdp.log;

-- 4)导入整个数据库

impdb system/manager@orcl directory=dump_dir dumpfile=full.dmp full=y logfile=impdp.log;

-- 5)追加数据

impdp system/manager@orcl directory=dump_dir dumpfile=expdp.dmp schemas=systemtable_exists_action logfile=impdp.log;

日常使用的:

把用户jcpt中所有的表导入到lyxt用户下

impdp lyxt/lyxt123@127.0.0.1/orcl directory=mydata dumpfile=LY.DMP remap_schema=jcpt:lyxt logfile=ims20171122.log table_exists_action=replace

11.10 数据误删

表中数据误删数据

场景: 现有 material_info 表 一条数据 被删除,知道大概的时间和关键字段 ‘攀登自锁器’

select * from material_info as of timestamp to_timestamp('2021-10-28 15:30:00', 'yyyy-mm-dd hh24:mi:ss')

where material_name like '%攀登自锁器%'

to_timestamp: 删除数据的大概时间 ,material_name 是表中字段,用来筛选数据的

表误删

11.52 数据库备份单个表

关键字 复制表、备份表

create table WORK_TASK_LIST__GROUNDWIRE_6 as select * from WORK_TASK_LIST__GROUNDWIRE;

create table myTable_tmpe as select * from myTable where 1=2;-- 只备份表结构,不复制表数据

create table sys_emp_1 as select * from sys_emp@xjbdblink;-- 使用dblink

11.53 oracle常用 函数

- replace 替换

select replace('123123tech', '123') from dual; --返回 'tech'============将 字符串 123123tech中123 去掉 最终结果是tech

select replace('123tech123', '123') from dual; --返回 'tech'

select replace('222tech', '2', '3') from dual; --返回 '333tech'============将字符串 222tech 中的2 替换为 3 最终结果是 333tech

select replace('0000123', '0') from dual; --返回 '123'

select replace('0000123', '0', ' ') from dual; --返回 ' 123'

- 截取 SUBSTR & INSTR

案例:截取 人员头像中的图片名称

select name,photo,substr(photo,instr(photo, '/',-1)+1),id from SYS_USER t where t.del_flag=0;

| 名称 | 头像路径 | 被截取文件名称 |

|---|---|---|

| aa | /userfiles/images/idCard/UserCertificate/1607081013003205402.jpg | 1607081013003205402.jpg |

| bb | /userfiles/images/idCard/UserCertificate/1304011138456401591.jpg | 1304011138456401591.jpg |

| cc | /userfiles/images/idCard/UserCertificate/1304110856309061782.jpg | 1304110856309061782.jpg |

案例:身份证号加密显示

SELECT DECODE(LENGTH(IDENTIFICATION),18,REPLACE(IDENTIFICATION,SUBSTR(IDENTIFICATION, 5, 10),'**********'),

15,REPLACE(IDENTIFICATION, SUBSTR(IDENTIFICATION, 5, 7),'*******')) 身份证号,

DECODE(LENGTH(mobile_number),11,REPLACE(mobile_number,SUBSTR(mobile_number, 8, 11),'****'),mobile_number) 手机号

FROM sys_emp;

ceil() /ceiling() 向上取整

ceil(1.2) = 2floor () 向下取整

floor(1.2) = 1round() 四舍五入

11.54 开窗函数,排序取最新

【Oracle】OVER(PARTITION BY)函数用法 开窗函数 https://www.cnblogs.com/ruiser/p/5687238.html

Oracle从8.1.6开始提供分析函数

11.55 取分组取第一条记录(关键字:取最新,取第一条数据,取最后一条)

切记用 row_number 而不是 DENSE_RANK

**注:**切记 使用时不能left join 关联其他表

最优方法:

select *

from (select USERID,

JD_GPS,

WD_GPS,

dwsj,

row_number() over(partition by USERID order by dwsj desc) mm

from ydxj_dw_dwjl_2016)

where mm = 1 // 要排过序后 才能 取第一条,不能直接就用rownum = 1 这样取出的数据,和没排序的一样

方法2

select a.*

from ydxj_dw_dwjl_2016 a

where not exists (select 1

from ydxj_dw_dwjl_2016 b

where b.userid = a.userid

and b.dwsj > a.dwsj)

方法3 用于 ,mysql没有 row_number函数时

select t.*

from ydxj_dw_dwjl_2016 t

where dwsj = (

select max(t1.dwsj) from proj_base_trajectory t1 where t1.USERID = t.USERID

)

11.60 列转行

日期行转列

SELECT TO_DATE('2021-05-01', 'YYYY-MM-DD') + ROWNUM - 1 DT FROM DUAL

CONNECT BY LEVEL <= (TO_DATE('2021-05-31', 'YYYY-MM-DD') - TO_DATE('2021-05-01', 'YYYY-MM-DD') + 1)

指定字符串 分割,转行

SELECT REGEXP_SUBSTR('1,2,3', '[^,]+', 1, LEVEL) NAME

FROM dual

CONNECT BY LEVEL <= REGEXP_COUNT('1,2,3', '[^,]+')

通过 GROUP_CONCAT

SELECT GROUP_CONCAT(user_id SEPARATOR ',') AS user_ids

FROM yj_zhst_user

- 如果数据量非常大,注意

GROUP_CONCAT的默认长度限制,在 MySQL 中可以通过以下方式增大限制:

SET SESSION group_concat_max_len = 1000000;

如果

案例:

工作票接地线表每个 条记录 多个接地线直接用逗号相连,现在要获取 当前工作票 选用的所以的接地线 思路:先讲数据行转列,然后再列转行,使用in

-- 先将 指定 工作票的接地线全部查询出来,然后逗号相连

with jdx_use_temp as

(select wm_concat(t.groundwire_no) jdx_code

from PLAN_WORK_TICKET_GROUNDWIRE t

where del_flag = 0

and ticket_id = 'd439b3cd225c4667a550f172844a397a')

select *

from jdx_device t

where t.code in

(SELECT REGEXP_SUBSTR(jdx_code, '[^,]+', 1, LEVEL) NAME -- 列转行,使用in

FROM jdx_use_temp

CONNECT BY LEVEL <= REGEXP_COUNT(jdx_code, '[^,]+'))

**注:**偶尔会出现死循环,目前遇到过一次,是因为不能加where 条件,可以使用子查询

例如 FROM jdx_use_temp --> FROM (select xx from jdx_use_temp where xx=xx)

myBatis 使用collection

< foreach collection="lineIds.split(',')" item="lineId" index="index" separator=", "> 目前最优,对数据格式没有过多要求

<select id="findLineByIds" resultMap="lineVOMap">

select t.id,

t.tower_pmsid,

t.line_id,

t.tower_name,

t.tower_no,

l.line_name

from BAS_C_TOWER t,bas_c_line l

where t.line_id=l.id

<if test="lineIds != null and lineIds != ''">

AND t.LINE_ID in (

<foreach collection="lineIds.split(',')" item="lineId" index="index" separator=", ">

#{lineId}

</foreach>

)

</if>

<if test="towerIds != null and towerIds != ''">

AND t.LINE_ID in (

select distinct line_id from bas_c_tower where id in (

<foreach collection="towerIds.split(',')" item="towerId" index="index" separator=", ">

#{towerId}

</foreach>

)

)

</if>

order by t.line_id, t.tower_no

</select>

<!-- 批量更新第一种方法,通过接收传进来的参数list进行循环着组装sql -->

<update id="updateBatch" parameterType="java.util.List" >

<foreach collection="list" item="item" index="index" open="" close="" separator=";">

update standard_relation

<set >

<if test="item.standardFromUuid != null" >

standard_from_uuid = #{item.standardFromUuid,jdbcType=VARCHAR},

</if>

<if test="item.standardToUuid != null" >

standard_to_uuid = #{item.standardToUuid,jdbcType=VARCHAR},

</if>

<if test="item.gmtModified != null" >

gmt_modified = #{item.gmtModified,jdbcType=TIMESTAMP},

</if>

</set>

where id = #{item.id,jdbcType=BIGINT}

</foreach>

</update>

<!-- 批量更新第二种方法,通过 case when语句变相的进行批量更新 -->

<update id="updateBatch" parameterType="java.util.List" >

update standard_relation

<trim prefix="set" suffixOverrides=",">

<trim prefix="standard_from_uuid =case" suffix="end,">

<foreach collection="list" item="i" index="index">

<if test="i.standardFromUuid!=null">

when id=#{i.id} then #{i.standardFromUuid}

</if>

</foreach>

</trim>

<trim prefix="standard_to_uuid =case" suffix="end,">

<foreach collection="list" item="i" index="index">

<if test="i.standardToUuid!=null">

when id=#{i.id} then #{i.standardToUuid}

</if>

</foreach>

</trim>

<trim prefix="gmt_modified =case" suffix="end,">

<foreach collection="list" item="i" index="index">

<if test="i.gmtModified!=null">

when id=#{i.id} then #{i.gmtModified}

</if>

</foreach>

</trim>

</trim>

where

<foreach collection="list" separator="or" item="i" index="index" >

id=#{i.id}

</foreach>

</update>

批量更新第三种方法,用ON DUPLICATE KEY UPDATE

<insert id="updateBatch" parameterType="java.util.List">

insert into standard_relation(id,relation_type, standard_from_uuid,

standard_to_uuid, relation_score, stat,

last_process_id, is_deleted, gmt_created,

gmt_modified,relation_desc)VALUES

<foreach collection="list" item="item" index="index" separator=",">

(#{item.id,jdbcType=BIGINT},#{item.relationType,jdbcType=VARCHAR}, #{item.standardFromUuid,jdbcType=VARCHAR},

#{item.standardToUuid,jdbcType=VARCHAR}, #{item.relationScore,jdbcType=DECIMAL}, #{item.stat,jdbcType=TINYINT},

#{item.lastProcessId,jdbcType=BIGINT}, #{item.isDeleted,jdbcType=TINYINT}, #{item.gmtCreated,jdbcType=TIMESTAMP},

#{item.gmtModified,jdbcType=TIMESTAMP},#{item.relationDesc,jdbcType=VARCHAR})

</foreach>

ON DUPLICATE KEY UPDATE

id=VALUES(id),relation_type = VALUES(relation_type),standard_from_uuid = VALUES(standard_from_uuid),standard_to_uuid = VALUES(standard_to_uuid),

relation_score = VALUES(relation_score),stat = VALUES(stat),last_process_id = VALUES(last_process_id),

is_deleted = VALUES(is_deleted),gmt_created = VALUES(gmt_created),

gmt_modified = VALUES(gmt_modified),relation_desc = VALUES(relation_desc)

</insert>

通过 sum 来 实现 列传行

场景说明:地图 我的附件,查询出 当前 驿站(yz)1个、人员2个 、GT 2个 、风险 2个

查询出 4条 不同类型的 记录,这种情况前端处理数据非常不方便,需要遍历。故需要将其转为 Map 对象,数据拉平

造数据

select 'yz' as type,1 as count_num from dual-- 驿站

union all

select 'user' as type,2 as count_num from dual--人员

union all

select 'tower' as type,2 as count_num from dual-- GT

union all

select 'fx' as type,2 as count_num from dual-- 风险

目前效果

| yz_num | user_num | tower_num | fx_num |

|---|---|---|---|

| 1 | 2 | 2 | 2 |

说明: 可以用decode,但是 MySql 不能使用,只能用case when

select

sum(case when type='yz' then count_num else 0 end) as yz_num,-- 也可以用 decode

sum(case when type='user' then count_num else 0 end) as user_num,

sum(case when type='tower' then count_num else 0 end) as tower_num,

sum(case when type='fx' then count_num else 0 end) as fx_num

from (

select 'yz' as type,1 as count_num from dual-- 驿站

union all

select 'user' as type,2 as count_num from dual--人员

union all

select 'tower' as type,2 as count_num from dual-- GT

union all

select 'fx' as type,2 as count_num from dual-- 风险

)aa

案例: 对人员岗位归类,positionName多个岗位逗号拼接的,如果存在 总监理工程师--> 总结,否则 总监代表--> 总代 ,否则 监理员 --> 监理员 ,都不是 则返回其他

select b.emp_id,

case

when INSTR(b.positionName, '总监理工程师') > 0 then '总监' --总监

when INSTR(b.positionName, '总监代表') > 0 then '总代' --总代

when INSTR(b.positionName, '监理员') > 0 then '监理员' --监理员

ELSE '其他' END as position

from v_user_position b

where b.positionName is not null

11.61 行转列

wm_concat 实现行转列(存在限定,拼接超过4000后异常)

mysql 等价的是

GROUP_CONCAT函数

select t.office_id,

wm_concat(t.area_id) areaIds, --replace(wm_concat(area_id),',','|') 通过 replace替换成需要的连接字符串

wm_concat(to_char(a.name)) as areaNames-- 对于中文可能会出现 转义

from ZHCG_OFFICE_MANAGE_AREA t, sys_area a

where t.del_flag = '0'

and a.del_flag = '0'

and t.area_id = a.id

group by office_id

- xmlagg

wm_concat ---函数实现字段合并 将返回的多条数据,,合并到一起,行转列,但是存在一个问题,拼接超过4000后异常

1.select XMLAGG(XMLELEMENT(E, name || ',')).EXTRACT('//text()').getclobval() as names from sys_user 但是好像不能使用分组函数

- xmlagg(xmlparse(content 拼接字段 || ','wellformed) order by 排序字段).getclobval()

案例:

SELECT

rtrim(xmlagg(xmlparse(content u.emp_name || ',' wellformed) ) .getclobval(), ',') userNames,

rtrim(xmlagg(xmlparse(content p.emp_id || ',' wellformed) ) .getclobval(), ',') userIds,

p.RULE_ID

from PROJ_BASE_ATTENDANCE_PERSON p

left join sys_emp u on u.id=p.emp_id

group by p.RULE_ID

注: rtrim(字段, ',') 去掉右边最后一个逗号

通过xmlagg讲数据转为clob ,也会存在字符缓存去限定长度

dbms_lob.substr( substr(rtrim(xmlagg(xmlparse(content a.id || ',' wellformed)) .getclobval(),',') ,0,200))

listagg 函数

SELECT listagg(t.ename,',') WITHIN GROUP(ORDER BY t.sal) FROM scott.emp t group by xxx;

- 使用REGEXP_SUBSTR

--1.

SELECT REGEXP_SUBSTR ('1,2,3', '[^,]+', 1,rownum)

from dual connect by rownum<=LENGTH ('1,2,3') - LENGTH (regexp_replace('1,2,3', ',', ''))+1;

-- 2.

select REGEXP_SUBSTR(t.rolecode, '[^,]+', 1, l) type

from (select '1,2' rolecode from dual) t,

(SELECT LEVEL l FROM DUAL CONNECT BY LEVEL <= 100) b

WHERE l <= LENGTH(t.rolecode) - LENGTH(REPLACE(rolecode, ',')) + 1

案例场景: 前端传递一个逗号拼接的字符串,sql中需要用in

select pe.emp_id from SYS_EMP_POST_EMP pe

where pe.position_id in (

SELECT REGEXP_SUBSTR (${positionIds}, '[^,]+', 1,rownum)

from dual connect by rownum <![CDATA[ <= ]]> LENGTH (${positionIds}) - LENGTH (regexp_replace(${positionIds}, ',', ''))+1

)

--'26438E087E604071886C69BC39B8A176,4358B8B6E93F4119847FF73766B72733'

11.65 ORACLE WITH AS 用法

with as优点 (相当于 创建一个临时表,然后后面可以直接调用 ) 增加了sql的易读性,如果构造了多个子查询,结构会更清晰; 更重要的是:“一次分析,多次使用”,这也是为什么会提供性能的地方,达到了“少读”的目标;

with e as (select * from scott.emp e where e.empno=7499)-- 相当于创建一个临时表

select * from e;

with

e as (select * from scott.emp),

d as (select * from scott.dept)

select * from e, d where e.deptno = d.deptno;

11.70 resultMap

resultMap可以实现将查询结果映射为复杂类型的pojo,比如在查询结果映射对象中包括pojo和list实现一对一查询和一对多查询

<resultMap type="cn.semdo.modules.projjl.entity.ProjJlEngineer" id="projJlEngineerMap">

<id column="ID" property="id"/>

<id column="engineerName" property="engineerName"/>

<collection property="projJlPositionList" ofType="cn.semdo.modules.projjl.entity.ProjJlPosition" column="engineerId">

<id column="positionId" property="id"/>

<id column="engineerId" property="engineerId"/>

<id column="positionName" property="name"/>

</collection>

</resultMap>

<select id="projJlEngineerList" resultMap="projJlEngineerMap">

SELECT

a.id,

a.engineer_Name as engineerName,

p.id AS "positionId",

p.engineer_id AS "engineerId",

p.name AS "positionName"

FROM proj_jl_engineer a

left join PROJ_JL_POSITION p on p.engineer_id = a.id

</select>

<!--column不做限制,可以为任意表的字段,而property须为type 定义的pojo属性-->

<resultMap id="唯一的标识" type="映射的pojo对象">

<id column="表的主键字段,或者可以为查询语句中的别名字段" jdbcType="字段类型" property="映射pojo对象的主键属性" />

<result column="表的一个字段(可以为任意表的一个字段)" jdbcType="字段类型" property="映射到pojo对象的一个属性(须为type定义的pojo对象中的一个属性)"/>

<association property="pojo的一个对象属性" javaType="pojo关联的pojo对象">

<id column="关联pojo对象对应表的主键字段" jdbcType="字段类型" property="关联pojo对象的主席属性"/>

<result column="任意表的字段" jdbcType="字段类型" property="关联pojo对象的属性"/>

</association>

<!-- 集合中的property须为oftype定义的pojo对象的属性-->

<collection property="pojo的集合属性" ofType="集合中的pojo对象">

<id column="集合中pojo对象对应的表的主键字段" jdbcType="字段类型" property="集合中pojo对象的主键属性" />

<result column="可以为任意表的字段" jdbcType="字段类型" property="集合中的pojo对象的属性" />

</collection>

</resultMap>

使用:Map<String, Object> getYhBihuanStatisData(JSONObject params);

<resultMap type="java.util.Map" id="yhBihuanStatisDataResult">

<result property="yhs" column="yhs" javaType="java.lang.Long" />

<result property="ybh" column="ybh" javaType="java.lang.Long" />

</resultMap>

<select id="getYhBihuanStatisData" resultMap="yhBihuanStatisDataResult" parameterType="com.alibaba.fastjson.JSONObject">

SELECT

count(1) yhs,

sum(case status when '5' then 1 else 0 end) ybh,

sum(case when FIND_TIME like '2022-09%' then 1 else 0 end) byxz,

sum(case when FIND_TIME like '2022-09%' and status = '5' then 1 else 0 end) bybh

FROM yh_op_record

WHERE del_flag = '0'

<!-- status:隐患状态

1:隐患库(暂存) 2:上报审核中 3:隐患管控中 4:闭环审核中

5:已闭环(正常) 6:重复上报(DEL_FLAG设为1) 7:误报(DEL_FLAG设为1)

-->

AND status != '1'

<if test="opTeamId!=null and opTeamId != ''">

AND op_team_id = #{opTeamId}

</if>

<if test="opOrgId!=null and opOrgId != ''">

AND op_org_id = #{opOrgId}

</if>

</select>

通过java 构造

// 以 parentId 分组(使用并行流)

Map<Long, List<TreeNode>> parentMap = nodeList.parallelStream()

.collect(Collectors.groupingByConcurrent(TreeNode::getParentId));

// 根节点列表

List<TreeNode> rootList = parentMap.get(0L);

// 递归构造树形结构

if (rootList != null) {

rootList.parallelStream().forEach(root -> {

buildTree(root, parentMap);

});

}

/**

* 递归构造树形结构

*

* @param node 节点

* @param parentMap 根据 parentId 分组的 Map

*/

private static void buildTree(TreeNode node, Map<Long, List<TreeNode>> parentMap) {

List<TreeNode> childList = parentMap.get(node.getId());

node.setChildren(childList);

if (childList != null) {

childList.forEach(child -> {

buildTree(child, parentMap);

});

}

}

工具类

通过java 构造树结构

List<TreeBean> tree = JavaFormatTreeUtil.getTree(list, "id",officeId);

js 构造

/**

* 组装树结构

* 考虑该功能可能需要离线使用,所以将数据获取到,通过js递归的形式,来组装数据

*/

var getTree=function(treeData,parentId){

var treeArr=[];

for(var i=0;i<treeData.length;i++){

var node=treeData[i];

if(node.parentId==parentId ){

var newNode={

id:node.id,

name:node.name,

parentId:node.parentId,

type:node.type,

nodeType:node.nodeType,

children:getTree(treeData,node.id)

};

treeArr.push(newNode);

}

}

return treeArr;

}

var treeArr=getTree(data,0);//将后台返回的数据,组装成树结构

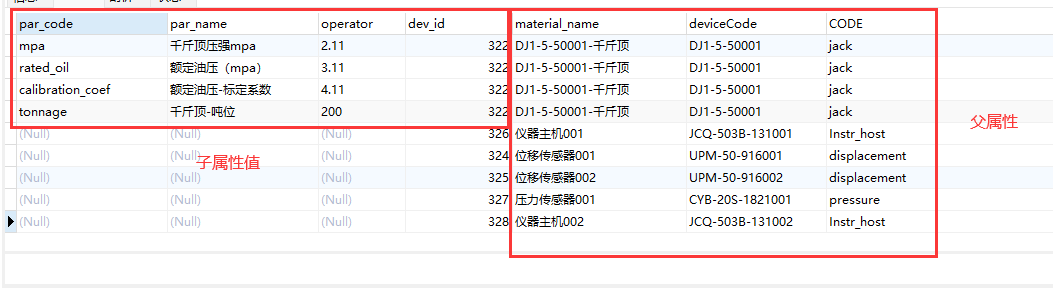

resultMap 构造树结构

<resultMap id="selectMaterialMap" type="cn.semdo.gdzjz.detectionManage.domain.vo.MaterialVO">

<result column="dev_id" property="id"/>

<result column="material_name" property="materialName"/>

<result column="deviceCode" property="deviceCode"/>

<result column="code" property="code"/>

<collection property="expandVOList" resultMap="expandResult" javaType="java.util.List"/>

</resultMap>

<resultMap id="expandResult" type="cn.semdo.gdzjz.detectionManage.domain.vo.MaterialExpandVO">

<result property="operator" column="operator"/>

<result property="parCode" column="par_code"/>

<result property="parName" column="par_name"/>

</resultMap>

<select id="selectMaterialData" resultMap="selectMaterialMap">

select e.par_code,e.par_name,e.operator,d.dev_id,info.material_name,t.code,info.material_Code as deviceCode

from zjjc_detection_device_relation d

inner join material_info info on info.id=d.dev_id

left join material_type t on t.id=info.typeid

left join material_info_expand e on e.material_id=d.dev_id

where d.del_flag=0 and d.proj_id=#{proId}

</select>

11.80 特殊字符

- 大于、小于

<![CDATA[ <= ]]>

11.81 oracle 查询记录为空,返回默认值 --- 在创建任务单单号的时候的应用

场景: 查询时 如果查询到那么就用查询的结果,如果查询不到,那么就给定一个默认值

分2中情况

1.可能不存在返回值 ,即一条数据都没有:

案例 表 dsj_line_tower_relation 存放 线路表存在的线路和 GT表中实际的线路

select nvl(MAX(t.tower_line_id),'bf3c8dd107a04d918a1d7f59365ccc26') from dsj_line_tower_relation t where line_id='bf3c8dd107a04d918a1d7f59365ccc26' --(使用max一定会有返回值,这样搭配 nvl 就可以实现返回值一定有结果)

传递我们指定的线路id,如果在****dsj_line_tower_relation**** 表中存在记录,那么就用查询的tower_line_id 否则,我们就返回我们传递的参数

查询时没有任何返回值,那么时不能用nvl() 来实现上面的效果

- 一定存在返回值,但是可能存在为空

select nvl(t.line_id,0) from ..................

11.90 存储过程

场景:每天根据 V_USER_WEIPAI 表(存放设备主人,GT,设备id,应该巡视次数)

https://blog.csdn.net/dwenxue/article/details/82257944 创建存储过程(带参数)

create or replace procedure PROC_WEIPAI_OP_EVERY_DAY as

--以机代巡中 设备巡视 每天统计

v_op_num NUMBER(10); -- 每天对应的 设备应拍次数(设置变量,下文中 会用到上面的查询结果)

begin

select nvl(max(OP_NUM), 3) into v_op_num from YDXJ_JOB_OP_NUM where trunc(OP_TIME) = trunc(SYSDATE); -- 每天对应的 设备应拍次数 赋值 (nvl(max(OP_NUM),0) 保证一定有值)

DELETE FROM YDXJ_WEIPAI_OP_COUNT_DAY WHERE trunc(OP_TIME) = trunc(SYSDATE); -- 删除今天数据,防止 数据重复添加

insert into ydxj_weipai_op_count_day (user_id, weipai_id, tower_id, op_time, should_op_num, op_num)

select a.userid, a.WEIPAIRECORD_ID, a.tower_id, sysdate,

v_op_num, -- 每个设备 应该巡视次数 (是上面语句中查询出来的数值)

nvl(op_.op_num,0) --每个设备 实际巡视次数

from V_USER_WEIPAI a

left join (select count(op.opid) as op_num, WEIPAIRECORD_ID,op.OPUSERID---讲数据分组后 left join 会提高查询速度

from ydxj_job_op op

where trunc(OPTIME) = trunc(SYSDATE)

and op.WEIPAIRECORD_ID is not null

group by WEIPAIRECORD_ID,op.OPUSERID) op_

on a.WEIPAIRECORD_ID = op_.WEIPAIRECORD_ID and op_.OPUSERID=a.userid;

Commit;

exception

when others then

raise;

rollback;

end;

创建 能传递参数的 存储过程

create or replace procedure test_page(

page_start in int,page_end in int,page_count out int,

page_emps out sys_refcursor)

as

begin

select count(*) into page_count from employees;

open page_emps for

select * from

(select rownum rn,e.* from employees e

where rownum <= page_end)

where rn >= page_start;

end test_page;

<?xml version="1.0" encoding="UTF-8" ?>

<!DOCTYPE mapper

PUBLIC "-//mybatis.org//DTD Mapper 3.0//EN"

"http://mybatis.org/dtd/mybatis-3-mapper.dtd">

<mapper namespace="com.lxj.mapper.EmployeeMapper">

<select id="getEmpById" resultType="com.lxj.bean.Employee">

select EMPLOYEE_ID id,LAST_NAME lastName,EMAIL email from employees

where EMPLOYEE_ID = #{id}

</select>

<!-- public void getEmpsByPage();

statementType="CALLABLE":调用存储过程,默认是PREPARED

call 不能丢,否则识别不出

-->

<select id="getEmpsByPage" statementType="CALLABLE">

{call test_page(

#{start,mode=IN,jdbcType=INTEGER},

#{end,mode=IN,jdbcType=INTEGER},

#{count,mode=OUT,jdbcType=INTEGER},

#{emps,mode=OUT,jdbcType=CURSOR,javaType=ResultSet,resultMap=TestPge}

)}

</select>

<resultMap type="com.lxj.bean.Employee" id="TestPge">

<id column="EMPLOYEE_ID" property="id"/>

<result column="LAST_NAME" property="lastName"/>

<result column="EMAIL" property="email"/>

</resultMap>

</mapper>

11.91 数据库定时器

19.100 DBLINK

需要保证 两个数据库之间网络是相通的,而不是 执行plsql 的本地的电脑和 目标数据库之间想通

查询数据库中的dblink select * from dba_db_links;

删除 drop database LINK SDTXJB_DBLINK;

--使用:比如协同办公需要移动巡检中的线路表(bas_c_linedsa) sdt_tyxxpt.bas_c_line@SDT_TYXXPT_DBLINK

create database link SDT_TYXXPT_DBLINK

connect to sdt_tyxxpt identified by sdt_tyxxpt

using '(DESCRIPTION =

(ADDRESS_LIST =

(ADDRESS = (PROTOCOL = TCP)(HOST = 192.168.10.225)(PORT = 1521))

)

(CONNECT_DATA =

(SERVER = DEDICATED)

(SID = yjdb2)

)

)';

create database link SDT_TYXXPT_DBLINK

connect to sdt_tyxxpt identified by sdt_tyxxpt

using '218.23.109.123:9522/yjdb';

19.110 oracle 自定义函数

参考https://blog.csdn.net/jumtre/article/details/38092067

--第一种不带参数:

create or replace function get_user

return varchar2 is Result varchar2(50); --定义变量(返回值)

begin

select username into Result from user_users; --into 赋值,不要忘了加分号结尾

return(Result); --返回值

end get_user;

--第二种带参:

create or replace function get_sal(empname in varchar2)

return numbe is Result number;

begin

select sal into Result from emp where ename=empname;

return(Result);

end;

自定义函数验证是否为数字

https://blog.csdn.net/vincentlee_/article/details/15336557

CREATE OR REPLACE FUNCTION isnumeric(str IN VARCHAR2)

RETURN NUMBER

IS

v_str FLOAT;

BEGIN

IF str IS NULL

THEN

RETURN 0;

ELSE

BEGIN

SELECT TO_NUMBER (str)

INTO v_str

FROM DUAL;

EXCEPTION --异常

WHEN INVALID_NUMBER

THEN

RETURN 0;

END;

RETURN 1;

END IF;

END isnumeric;

经纬度距离计算

CREATE OR REPLACE FUNCTION F_DISTANCE (cx in number,cy in number,sx in number, sy in number)

RETURN NUMBER

is

d number;

x number;

y number;

r number;

pi number;

begin

r:=6371229;--地球半径

pi:=3.14159265358979323;--圆周率

x:=(sx-cx)*pi*r*cos((sy+cy)/2*pi/180)/180;

y:=(sy-cy)*pi*r/180;

d:=SQRT(power(x,2)+power(y,2));

D:=ROUND(D,2);

RETURN d;

end ;

11.120 查询指定用户 表名+数据量+表备注

SELECT t.table_name, t.num_rows, f.comments

FROM all_tables t

INNER JOIN ( SELECT * FROM all_tab_comments WHERE OWNER = 'CPMS_DEV' ) f ON t.table_name = f.table_name

WHERE t.OWNER = 'CPMS_DEV'

11.130 时间排序,存在null 导致 排列到最前面

Nulls first (记录将排在最前)和nulls last(记录将排在最后)是Oracle Order by支持的语法

select * from FORUM t order by last_reply_time desc nulls last ,id desc ;

select *

from (select row_number() over(partition by id order by receive_time desc nulls last) mm,a.*

from sys_push_send_ref_temp a

) where mm = 1

decode

decode(filed,null,’张三’, filed)表示当filed为空时则返回’张三’,如果不为空则返回filed本来的值(不仅可以判断null,也可以判断特定的值)

使用 nvl

select * from FORUM t order by NVL(last_reply_time, to_date('1970-01-01 00:00:00','yyyy/MM/dd/hh24/mi/ss')) desc ;

11.140 案例:

消息 有多层级,现在需要 获取 根节点并展示指定用户最新的消息

with sys_push_send_ref_temp as(

select root_modules_id as id,root_modules_name as modulesName,root_modules_code,aa.modules_id,aa.name,root_msg_url_app as msgUrlApp,

aa.root_modules_icon modulesIcon,bb.receive_status,bb.receive_time,bb.message,bb.CONTENT_ID

from (select connect_by_root id as root_modules_id,--

connect_by_root MODULES_NAME as root_modules_name,

connect_by_root MODULES_CODE as root_modules_code,

connect_by_root modules_icon as root_modules_icon,

connect_by_root msg_url_app as root_msg_url_app,

id modules_id, t.MODULES_NAME,MODULES_CODE,

lpad(' - - - - - - -', (level - 1) * 10, ' ') || t.MODULES_NAME as name --节点名称(带缩进)

from sys_Push_Modules t where del_flag = '0'

-- 核心写法,通过递归 重构 sys_Push_Modules 获取每个消息类型的根节点信息

start with PARENT_ID is null --递归的写法,从指定节点,查询其下面的所有数据

connect by t.PARENT_ID = prior t.id) aa

left join (select a.receive_status,a.receive_time,c.modules_id,c.message,a.CONTENT_ID-- 用来获取 每个类型的消息

from sys_push_send_ref a, sys_push_content c

where c.id = a.content_id and a.receive = '02049cdfa3904602add9b85e2951f767') bb

on bb.modules_id = aa.modules_id

)

select a.id,a.modulesIcon,b.count,a.modulesName,a.receive_time,a.message,a.msgUrlApp

from (

select id,modulesIcon,modulesName,message,msgUrlApp ,receive_time

from (select row_number() over(partition by id order by receive_time desc nulls last) mm,a.*

from sys_push_send_ref_temp a

) where mm = 1 -- 获取每个 更节点 最新的一条消息

)a

left join(-- 获取未读消息的数量

select count(1) count,id

from sys_push_send_ref_temp a

where receive_status=0 and CONTENT_ID is not null

group by id

) b on b.id=a.id

order by a.receive_time desc nulls last

主要思路: 用递归遍历,connect_by_root 标记出 每个消息类型对应的 根节点 信息,这样关联消息表,就能获取每个消息对应的根节点id。然后取最新一条

11.200

between xx and yy ;

11.210 oracle 对时间的处理

1. trunc

select trunc(sysdate,'HH24')-1/24 from dual; -- 当前时间前一个小时 并且小时取整 2021/4/30 13:00:00

select TRUNC(SYSDATE, 'MM') from dual;-- 2023/8/1

-- TRUNC(SYSDATE, 'YYYY') 将当前日期截断为当前年份的第一天,然后通过加上 INTERVAL '1' YEAR - INTERVAL '1' DAY 得到当前年份的最后一天

SELECT TRUNC(SYSDATE, 'YYYY') + INTERVAL '1' YEAR - INTERVAL '1' DAY AS year_end FROM dual; -- 2023/12/31

SELECT TRUNC(ADD_MONTHS(SYSDATE, 12), 'YYYY') AS next_year_first_day FROM dual; -- 下一年的最后一天

2.日期行转列

SELECT TO_DATE('2021-05-01', 'YYYY-MM-DD') + ROWNUM - 1 DT FROM DUAL

CONNECT BY LEVEL <= (TO_DATE('2021-05-31', 'YYYY-MM-DD') - TO_DATE('2021-05-01', 'YYYY-MM-DD') + 1)

3. 两时间相加减

https://www.cnblogs.com/zhaojinhui/p/3999469.html

注: Oracle date 日期相减 注意 sysdate 为date 类型,所有如果 TIMESTAMP(6) 类型责需要

sysdate-to_date(to_char(time,'yyyy-mm-dd hh24-mi-ss'),'yyyy-mm-dd hh24-mi-ss')

--oracle 两个时间相减默认的是天数

--oracle 两个时间相减默认的是天数*24 为相差的小时数

--oracle 两个时间相减默认的是天数*24*60 为相差的分钟数

--oracle 两个时间相减默认的是天数*24*60*60 为相差的秒数

--MONTHS_BETWEEN(date2,date1)

--给出date2-date1的月份

select months_between('19-12月-1999','19-3月-1999') mon_between from dual;

--MON_BETWEEN

select months_between(to_date('2000.05.20','yyyy.mm.dd'),to_date('2005.05.20','yyyy.dd')) mon_betw from dual;

-- MON_BETW

-- Oracle计算时间差表达式

--获取两时间的相差豪秒数

select ceil((To_date('2008-05-02 00:00:00' , 'yyyy-mm-dd hh24-mi-ss') - To_date('2008-04-30 23:59:59' , 'yyyy-mm-dd hh24-mi-ss')) * 24 * 60 * 60 * 1000) 相差豪秒数 FROM DUAL;

--获取两时间的相差秒数

select ceil((To_date('2008-05-02 00:00:00' , 'yyyy-mm-dd hh24-mi-ss') - To_date('2008-04-30 23:59:59' , 'yyyy-mm-dd hh24-mi-ss')) * 24 * 60 * 60) 相差秒数 FROM DUAL;

--获取两时间的相差分钟数

select ceil(((To_date('2008-05-02 00:00:00' , 'yyyy-mm-dd hh24-mi-ss') - To_date('2008-04-30 23:59:59' , 'yyyy-mm-dd hh24-mi-ss'))) * 24 * 60) 相差分钟数 FROM DUAL;

--获取两时间的相差小时数

select ceil((To_date('2008-05-02 00:00:00' , 'yyyy-mm-dd hh24-mi-ss') - To_date('2008-04-30 23:59:59' , 'yyyy-mm-dd hh24-mi-ss')) * 24) 相差小时数 FROM DUAL;

--获取两时间的相差天数

select ceil((To_date('2008-05-02 00:00:00' , 'yyyy-mm-dd hh24-mi-ss') - To_date('2008-04-30 23:59:59' , 'yyyy-mm-dd hh24-mi-ss'))) 相差天数 FROM DUAL;

----------------------------------------

注:天数可以2个日期直接减,这样更加方便

----------------------------------------

--获取两时间月份差

select (EXTRACT(year FROM to_date('2009-05-01','yyyy-mm-dd')) - EXTRACT(year FROM to_date('2008-04-30','yyyy-mm-dd'))) * 12 +

EXTRACT(month FROM to_date('2008-05-01','yyyy-mm-dd')) - EXTRACT(month FROM to_date('2008-04-30','yyyy-mm-dd')) months

from dual;

--------------------------------------

注:可以使用months_between函数,更加方便

--------------------------------------

--获取两时间年份差

select EXTRACT(year FROM to_date('2009-05-01','yyyy-mm-dd')) - EXTRACT(year FROM to_date('2008-04-30','yyyy-mm-dd')) years from dual;

select sysdate,add_months(sysdate,12) from dual; --加1年

select sysdate,add_months(sysdate,1) from dual; --加1月

select sysdate,TO_CHAR(sysdate+7,'yyyy-mm-dd HH24:MI:SS') from dual; --加1星期

select sysdate,TO_CHAR(sysdate+1,'yyyy-mm-dd HH24:MI:SS') from dual; --加1天

select sysdate,TO_CHAR(sysdate+1/24,'yyyy-mm-dd HH24:MI:SS') from dual; --加1小时

select sysdate,TO_CHAR(sysdate+1/24/60,'yyyy-mm-dd HH23:MI:SS') from dual; --加1分钟

select sysdate,TO_CHAR(sysdate+1/24/60/60,'yyyy-mm-dd HH23:MI:SS') from dual; --加1秒

select sysdate+7 from dual; --加7天

4.oracle验证2个时间是否有交集,时间重叠

select *

from test_table

where (startTime > a AND startTime < b) OR

(startTime < a AND endTime > b) OR

(endTime > a AND endTime < b)

5. 年份比较

SELECT *

FROM your_table

WHERE EXTRACT(YEAR FROM your_date) = EXTRACT(YEAR FROM SYSDATE); -- 验证your_date 是否是 今年

11.220 oracle 递归

select

connect_by_root t.name as func_name_4_root ,t.type

,lpad(' - - - - - - -', (level - 1) * 10, ' ') || t.name as "name" --节点名称(带缩进)

, SYS_CONNECT_BY_PATH(name, '/') as pName

from sys_office t

start with id='xjbwgzb' --递归的写法,从指定节点,查询其下面的所有数据 (不可为空,否则查出的数据,会重复)

connect by t.parent_id=prior t.id;

说明:

CONNECT_BY_ROOT 返回当前节点的最顶端节点 ---->connect_by_root t.name 返回的就是根节点的名称

CONNECT_BY_ISLEAF 判断是否为叶子节点,如果这个节点下面有子节点,则不为叶子节点

LEVEL 伪列表示节点深度 ------> 可以作为节点的层级

SYS_CONNECT_BY_PATH函数显示详细路径,并用“/”分隔----> 拼接节点,可以找到所以父节点

参考:https://blog.csdn.net/feier7501/article/details/21815691

向上递归 id 最小级别

select distinct name,type,id

from sys_office t

start with id = '0192e1d8c9d34eab89ec0csedwewefweffw3434345633s'

connect by prior parent_id = id

向下递归 id 最大级别

select distinct name ,type,id

from sys_office t

start with t.id = 'xjbwgzb'

connect by prior id = parent_id

案例:场景:查询人员的所属部门,office表结构为 公司-部门-团队,其中部门和团队都挂人员,而团队下的人员也要归属于部门下

select * from sys_office t

where t.type = '2' --type=2 表示团队

connect by prior t.id=t.parent_id

start with t.id ='xxxxxx' ---当前人员的所属机构

11.230 grant 权限 on 数据库对象 to 用户

# 给 SDT_XJB系统 添加 SDT_IMOA 用户下的SYS_USER 表的select权限

grant select on SYS_USER to SDT_IMOA ;

#

select 'grant select on '||table_name ||' to SDT_XJB ;' from all_tables where owner='SDT_IMOA';

说明: 现在需要创建一个视图,用来 协同办公和巡检保 用户表对照

分别 在 SDT_XJB用户下执行 grant select on SYS_USER to SDT_IMOA ;

在 SDT_IMOA用户下执行 grant select on SYS_USER to SDT_XJB;

create or replace view v_user_xjb_imoa as(

/*

巡检保和 协同办公人员对照表

*/

select imoa_u.login_name as imoa_login_name,

imoa_u.id as imoa_id,

imoa_u.name as imoa_name,

imoa_u.office_id as imoa_office_id,

xjb_u.login_name as xjb_login_name,

xjb_u.id as xjb_id,

xjb_u.name as xjb_name,

xjb_u.office_id as xjb_office_id

from SDT_IMOA.sys_user imoa_u, SDT_XJB.sys_user xjb_u

where imoa_u.login_name = xjb_u.login_name -- imoa_u.del_flag=0 and xjb_u.del_flag=0

);

11.240 聚合

数据库中找到表中重复数据 oracle查询重复数据方法

找到表中 model_name 出现重复的记录

select * from BAS_TOWER_TYPE where MODEL_NAME in (

select MODEL_NAME from BAS_TOWER_TYPE where model_name='J27102'

group by MODEL_NAME

having count(id) > 1

)

11.250 查询数据库中表是否被锁

select object_name,machine,s.sid,s.serial#

from v$locked_object l,dba_objects o ,v$session s

where l.object_id = o.object_id and l.session_id=s.sid;

11.500 数据库异常

1.数据库 连接不上,也不报错

可能是 listener.log 文件已经达到4G 无法再继续写入参考:https://blog.csdn.net/obgnahs/article/details/81410569

解决:删除D:\app\Administrator\diag\tnslsnr\计算机名\listener\trace目录下listener.log文件

重启service服务及数据库实例服务

2. 数据库锁表

查看Oracle被锁的表以及如何解锁:https://blog.csdn.net/liusa825983081/article/details/80448945

- 1.查看是否有被锁的表:

select b.owner,b.object_name,a.session_id,a.locked_mode

from v$locked_object a,dba_objects b

where b.object_id = a.object_id

- 2.查看是哪个进程锁的

select b.username,b.sid,b.serial#,logon_time

from v$locked_object a,v$session b

where a.session_id = b.sid order by b.logon_time

| username | sid | serial# | logon_time |

|---|---|---|---|

| SDT_XJB | 435 | 29253 | 2021/10/8 9:04:22 |

杀死进程

alter system kill session 'sid,serial#';

-- alter system kill session '435,29253';

Oracle ORA-12514 解决办法

- 找到listener.ora监听文件,具体位置如:

C:\app\Administrator\product\11.2.0\dbhome_1\network\admin\listener.ora

2.在lisener.ora文件中添加下方加红加粗部分:

# listener.ora Network Configuration File: C:\app\Administrator\product\11.2.0\dbhome_1\network\admin\listener.ora

# Generated by Oracle configuration tools.

SID_LIST_LISTENER =

(SID_LIST =

(SID_DESC =

(SID_NAME = CLRExtProc)

(ORACLE_HOME = C:\app\Administrator\product\11.2.0\dbhome_1)

(PROGRAM = extproc)

(ENVS = "EXTPROC_DLLS=ONLY:C:\app\Administrator\product\11.2.0\dbhome_1\bin\oraclr11.dll")

)

# ==============添加下面的语句===========

(SID_DESC =

(GLOBAL_DBNAME = ORCL)

(ORACLE_HOME = C:\app\Administrator\product\11.2.0\dbhome_1)

(SID_NAME = ORCL)

)

# =================================

)

LISTENER =

(DESCRIPTION_LIST =

(DESCRIPTION =

(ADDRESS = (PROTOCOL = IPC)(KEY = EXTPROC1521))

(ADDRESS = (PROTOCOL = TCP)(HOST = WIN-UBKOOK0BP2K.geostar.com.cn)(PORT = 1521))

)

)

ADR_BASE_LISTENER = C:\app\Administrator

ORA-01033 问题解决办法

https://www.cnblogs.com/iqingchun/p/13538103.html

Oracle归档日志满了导致无法启动ora-03113

案例:(使用过)

# 1.登陆(https://www.cnblogs.com/gmq-sh/p/5980127.html)

sqlplus /nolog

SQL> connect /as sysdba

# 2.检查flash recovery area的使用情况,可以看见archivelog已经很大了,达到99.94

SQL> select * from V$FLASH_RECOVERY_AREA_USAGE;

# 3.计算flash recovery area已经占用的空间

SQL> select sum(percent_space_used)*3/100 from v$flash_recovery_area_usage;

# 4.修改FLASH_RECOVERY_AREA的空间修改为8GB,修改前确认磁盘有足够空间

SQL> ALTER SYSTEM SET DB_RECOVERY_FILE_DEST_SIZE=8g

# 5.清理一下archivelog归档日志,生产环境建议备份

## 5.1查询日志目录位置

show parameter recover;

## 5.2删除归档日志,orcl是数据库实例名 (手动删除文件)

D:\app\Administrator\flash_recovery_area\orcl\ARCHIVELOG

# 6.使用rman 操作

$ rman

RMAN> connect target sys/sys_passwd

crosscheck backup;

delete obsolete;

delete expired backup;

crosscheck archivelog all;

delete expired archivelog all;

#### 此步会有提示,输入 YES 回车

host; //退出rman

# 7.确认是否操作成功

sqlplus /nolog

SQL> connect /as sysdba

SQL> select * from V$FLASH_RECOVERY_AREA_USAGE;

ORACLE 归档日志打开关闭方法

sql> archive log list; #查看是否是归档方式

sql> alter system set log_archive_start=false scope=spfile; #禁用自动归档

sql> shutdown immediate;

sql> startup mount; #打开控制文件,不打开数据文件

sql> alter database noarchivelog; #将数据库切换为非归档模式

sql> alter database open; #将数据文件打开

sql> archive log list; #查看此时便处于非归档模式

//=== 待测试

sqlplus / as sysdba

shutdown abort ----关闭进程

startup mount ---- 装载数据库

select * from v$recovery_file_dest; ---查询归档日志

ALTER SYSTEM SET DB_RECOVERY_FILE_DEST_SIZE=10737418240; --设置归档日志空间为10G

https://www.cnblogs.com/-txf-/p/11572942.html

oracle归档日志满了无法启动数据库问题解决记录

sqlplus /nolog

conn /as sysdba

上面的登录方式提示12560协议适配器错误

sqlplus sys/sys@orcl as sysdba 这个语句就可以直接登录

conn sys/sys as sysdba;

然后将oracle关闭shutdown immediate;

再启动到mount模式 statrup mount

更改数据库的归档模式

SELECT * FROM V$FLASH_RECOVERY_AREA_USAGE;--查询归档日志大小

select log_mode from v$database;--查询归档模式

alter database noarchivelog;--更改数据库到非归档模式

接下来删除过多的归档日志文件

先物理删除日期较前的归档日志(可以剪切到别处),归档日志文件位置D:\app\Administrator\flash_recovery_area\orcl\ARCHIVELOG

再打开一个cmd窗口

执行 $ rman target / nocatalog;

crosscheck archivelog all;--检查归档日志文件

delete expired archivelog all;--删除过期的日志文件

接下来重新启动oracle即可

rman 执行 可能会报错,前面加上$

include 的用法

<sql id="sqlid">

res_type_id,res_type

</sql>

<select id="queryPubResType" parameterType="com.property.vo.PubResTypeVO" resultMap="PubResTypeList">

select a.res_type_id,

<include refid="sqlid">

<property name="AI_RES_TYPE_ID" value="a.res_type_id"/>

<property name="lng" value="#{lngId}"/>

<property name="female" value="'女'"/>

</include> as res_type

from pub_res_type a

</select>

<select id="queryPubResType" parameterType="com.property.vo.PubResTypeVO" resultMap="PubResTypeList">

select a.res_type_id,

<include refid="sqlid"/>

from pub_res_type a

</select>

验证是否包含(是否有交集)

-- 场景1

(#{选择结束点} BETWEEN 开始点 and 结束点)

-- 场景2、3

or (#{选择开始点} BETWEEN 开始点 and 结束点)

-- 场景4

or (

#{选择结束点} >= 结束点 and #{选择开始点} <![CDATA[ <= ]]> 开始点

)

表空间相关

查询表空间大小

SELECT

a.tablespace_name, -- 表空间名称

b.bytes / 1024 / 1024 AS total_size_mb, -- 总大小 (MB)

(b.bytes - NVL(c.bytes, 0)) / 1024 / 1024 AS used_size_mb, -- 已使用 (MB)

NVL(c.bytes, 0) / 1024 / 1024 AS free_size_mb -- 可用 (MB)

FROM

dba_tablespaces a

JOIN

(SELECT tablespace_name, SUM(bytes) AS bytes

FROM dba_data_files

GROUP BY tablespace_name) b ON a.tablespace_name = b.tablespace_name

LEFT JOIN

(SELECT tablespace_name, SUM(bytes) AS bytes

FROM dba_free_space

GROUP BY tablespace_name) c ON a.tablespace_name = c.tablespace_name

ORDER BY

a.tablespace_name;

表空间满了

-- 查询表空间对应的文件位置

select name from v$datafile;

-- 查询总量 size_mb

SELECT file_name,

bytes/1024/1024 AS size_mb,

(bytes - NVL(free_bytes, 0))/1024/1024 AS used_mb

FROM (

SELECT df.file_name,

df.bytes,

SUM(fs.bytes) AS free_bytes

FROM dba_data_files df

LEFT JOIN dba_free_space fs ON df.file_id = fs.file_id

WHERE df.file_name = 'D:\APP\LISHIHUAN\ORADATA\ORCL\SDT_IMOA.DBF'

GROUP BY df.file_name, df.bytes

);

-- 2560M 这个数值要比上面查询到的size_mb 大

ALTER DATABASE DATAFILE 'D:\APP\LISHIHUAN\ORADATA\ORCL\SDT_IMOA.DBF' RESIZE 2560M;

查询表空间中表、索引占用空间

SELECT

a.tablespace_name,

b.segment_name,

b.segment_type,

SUM(b.bytes) / 1024 / 1024 AS used_size_mb

FROM

dba_segments b

JOIN

dba_tablespaces a ON b.tablespace_name = a.tablespace_name

WHERE a.tablespace_name = 'SDT_IMOA' -- 替换为你的表空间名称

GROUP BY

a.tablespace_name, b.segment_name, b.segment_type

ORDER BY

used_size_mb DESC;

创建只读用户

- 原始用户 SDT_YJWZ

- 创建只读用户semdo_wz

-- 1. 创建用户

CREATE USER semdo_wz IDENTIFIED BY semdo_wz;

-- 2. 授予该用户连接到数据库的权限

GRANT CONNECT TO semdo_wz;

-- 3. 授权

-- 3.1 指定表

GRANT SELECT ON schema_name.table_name TO semdo_wz;

-- 3.2 如果您希望用户具有访问所有表的权限,可以授予 ALL 权限。

GRANT SELECT ANY TABLE TO semdo_wz;

-- 4. 查询

sqlplus query_user/password@your_database

---- 查询表

SELECT * FROM SCHEMA_NAME.table_name; ## SCHEMA_NAME 指的是 用户SDT_YJWZ

GRANT SELECT ON SDT_YJWZ.material_code_relation TO semdo_wz;

GRANT SELECT ON SDT_YJWZ.material_sub_detail TO semdo_wz;

要为 semdo_wz 用户创建一个只具有查询功能的数据库用户,你需要按照以下步骤操作:

步骤 1:创建 semdo_wz 用户

首先,管理员需要在数据库中创建一个新用户 semdo_wz,并为该用户分配密码。你可以在 SQL*Plus 或者 SQL Developer 中使用以下命令:

CREATE USER semdo_wz IDENTIFIED BY password;

这里,password 是你为 semdo_wz 用户选择的密码。

步骤 2:授予连接和查询权限

接下来,你需要为 semdo_wz 用户授予必要的权限,以便它能够登录并执行查询。

授予连接权限: 使用户能够连接到数据库。

GRANT CONNECT TO semdo_wz;授予查询权限: 为了让

semdo_wz用户能够查询表数据,你需要授予SELECT权限。假设semdo_wz用户需要查询SDT_YJWZ用户下的表,你可以授予这些表的查询权限。如果你希望用户查询

SDT_YJWZschema 下的所有表,你可以执行如下命令(对于每个表):GRANT SELECT ON SDT_YJWZ.table_name TO semdo_wz;如果你希望为所有表授予查询权限,可以使用动态查询脚本:

BEGIN FOR r IN (SELECT table_name FROM all_tables WHERE owner = 'SDT_YJWZ') LOOP EXECUTE IMMEDIATE 'GRANT SELECT ON SDT_YJWZ.' || r.table_name || ' TO semdo_wz'; END LOOP; END;这段 PL/SQL 脚本会自动为

SDT_YJWZ用户下的所有表授予SELECT权限给semdo_wz用户。

步骤 3:可选 — 授予特定角色

如果你不想逐个表授予权限,也可以为 semdo_wz 用户分配一个角色,角色中包含所需的权限。

比如,创建一个角色并授予 SELECT 权限,然后将角色分配给 semdo_wz 用户:

创建角色:

CREATE ROLE query_role;授予角色查询权限:

GRANT SELECT ON SDT_YJWZ.table_name TO query_role;将角色分配给用户:

GRANT query_role TO semdo_wz;

步骤 4:测试用户权限

创建好 semdo_wz 用户并授予权限后,测试该用户是否能够登录并查询数据:

登录:

sqlplus semdo_wz/password@127.0.0.1:1521/orcl执行查询:**需要注意查询表的时候,需要带上用户名 **

SELECT * FROM SDT_YJWZ.table_name;

如果一切正常,semdo_wz 用户应该能够查询 SDT_YJWZ 用户下的表。

步骤 5:配置 JDBC

在你的 Java 应用程序中,你需要将数据库连接信息配置为使用 semdo_wz 用户。假设你的 jdbc.url 和数据库连接信息如下:

jdbc.url=jdbc:oracle:thin:@127.0.0.1:1521/orcl

jdbc.username=semdo_wz

jdbc.password=password

确保在 jdbc.username 和 jdbc.password 中使用 semdo_wz 用户的凭据。

总结

- 创建用户:使用

CREATE USER创建semdo_wz用户。 - 授予权限:授予连接权限和

SELECT权限。 - 配置 JDBC:在你的应用程序中更新数据库连接信息,使用

semdo_wz用户。

通过这些步骤,你将能够创建一个只具有查询权限的用户 semdo_wz,并配置其数据库连接。

oracle 删除表等并且释放空间

- 删除表、视图、索引等

BEGIN

-- 删除表

FOR r IN (SELECT table_name, owner FROM all_tables WHERE owner = 'SDT_ZHST_2024') LOOP

EXECUTE IMMEDIATE 'DROP TABLE ' || r.owner || '.' || r.table_name || ' CASCADE CONSTRAINTS';

END LOOP;

-- 删除视图

FOR r IN (SELECT view_name, owner FROM all_views WHERE owner = 'SDT_ZHST_2024') LOOP

EXECUTE IMMEDIATE 'DROP VIEW ' || r.owner || '.' || r.view_name;

END LOOP;

-- 删除索引

FOR r IN (SELECT index_name, owner FROM all_indexes WHERE owner = 'SDT_ZHST_2024') LOOP

EXECUTE IMMEDIATE 'DROP INDEX ' || r.owner || '.' || r.index_name;

END LOOP;

-- 删除存储过程、函数、包等

FOR r IN (SELECT object_name, object_type, owner FROM all_objects WHERE owner = 'SDT_ZHST_2024' AND object_type IN ('PROCEDURE', 'FUNCTION', 'PACKAGE')) LOOP

EXECUTE IMMEDIATE 'DROP ' || r.object_type || ' ' || r.owner || '.' || r.object_name;

END LOOP;

END;

/

- 删除用户

DROP USER SDT_ZHST_2024 CASCADE;

- 手动删除数据文件

如果删除表空间时仍然没有删除数据文件,您可以手动删除数据文件。要确保数据文件已经从表空间中移除,可以执行以下命令:

首先,使用

ALTER DATABASE命令将数据文件脱离表空间:ALTER DATABASE DATAFILE 'D:\app\lishihuan\oradata\orcl\SDT_ZHST_2024.DBF' OFFLINE;然后,删除数据文件:

HOST del D:\app\lishihuan\oradata\orcl\SDT_ZHST_2024.DBF;HOST命令用于在 SQL*Plus 中执行操作系统级别的命令,删除数据文件。

12. MySql

注: java 程序配置 MySql数据库时需要注意

mysql 权限:https://yunwei.blog.csdn.net/article/details/106424312

因为在mysql5中,jdbc的驱动是com.mysql.jdbc.Driver,

而mysql6以及以上是com.mysql.cj.jdbc.Driver

老板:

jdbc.type=mysql

jdbc.driver=com.mysql.jdbc.Driver

jdbc.url=jdbc:mysql://192.168.2.149:3306/cpms_cz_dev?useUnicode=true&characterEncoding=utf-8&autoReconnect=true&failOverReadOnly=false&allowMultiQueries=true

jdbc.username=root

jdbc.password=root

?nullCatalogMeansCurrent=true 新版本-8:需要加 ?useUnicode=true&characterEncoding=utf-8&useSSL=false&serverTimezone =Asia/Shanghai

jdbc.type=mysql

jdbc.driver=com.mysql.cj.jdbc.Driver

jdbc.url=jdbc:mysql://192.168.2.149:3306/cpms_cz_dev?useUnicode=true&characterEncoding=utf-8&autoReconnect=true&failOverReadOnly=false&allowMultiQueries=true

#url: jdbc:mysql://localhost:3306/restful_crud?useUnicode=true&characterEncoding=utf-8&useSSL=false&serverTimezone =Asia/Shanghai

jdbc.username=root

jdbc.password=root

xml文件中 & === > &

12.1 基本使用

cmd登陆:mysql -h 192.168.10.229 -p 9060 -uroot -pSemdo@123

查看数据库的语句是

SHOW DATABASES,查看数据库语法格式是:

SHOW DATABASES [LIKE '数据库名'];

mysql> SHOW DATABASES LIKE '%test%';

- 创建用户

CREATE USER 'lishihuan'@'172.16.10.229' IDENTIFIED BY '123456';

授权

删除用户

DROP USER 'lishihuan'@'172.16.10.229';

- 查询建表语句

SHOW CREATE TABLE table_name;

- 查询字段 属性

desc table_name;

- 切换数据库

use sdt_xjb;

删除表:

DROP TABLE my_table;删除数据(分场景,如果全删,用 truncate)

- 删除整表数据

truncate table my_table; - 删除部分数据

delete from my_table where id='1';

delete from sys_job_log; -- 遇到无法删除,因为磁盘存储空间满了 truncate table sys_job_log; optimize table sys_job_log;- 删除整表数据

查询进程

show processlist;

- 添加字段

## 表BAS_OP_TEAM 添加 字段LONGITUDE_GB 并且插入位置再PHONE字段后面

ALTER TABLE BAS_OP_TEAM ADD LONGITUDE_GB varchar(200) comment '所在位置经度(国标)' after PHONE;

ALTER TABLE OD_SHIFT_RECORD ADD `CODE` varchar(50) not null comment '班次CODE【唯一标识】' after START_DATE;

- 复制表结构

-- 备份表机构

create table yj_zhst_user_dept like yj_zhst_user ;

12.5 MySql ddl 语句

添加联合约束

ALTER TABLE climate_collect_pjrelation ADD unique(DEVICE_ID, ENGINEER_ID)

设置主键自增长

alter table workflow_leave modify id int auto_increment primary key;

alter table workflow_leave modify id int auto_increment;

删除时存在外键

使用delete 无法讲id自增长 序号清除

-- 禁用外键约束

SET FOREIGN_KEY_CHECKS = 0;

-- 执行 TRUNCATE 操作

TRUNCATE TABLE `yjydxj-cloud`.`emg_bus_imit_actv_matr_rec`;

-- 启用外键约束

SET FOREIGN_KEY_CHECKS = 1;

12.9 数据类型-整数

| 字段类型 | 名称 | 字节数 | 表示范围 |

|---|---|---|---|

| tinyint | 迷你整型 | 1个字节=8位 | 0-255 |

| smallint | 小整型 | 2个字节 | 0-65535 |

| mediumint | 中整型 | 3个字节 | - |

| int | 整型(标准整型) | 4个字节 | - |

| bigint | 大整型 | 8个字节 | - |

12.10 列转行

select a.id,a.name,a.label,substring_index(substring_index(a.value_item,';',b.help_topic_id+1),';',-1) value_item

from YH_BASE_DEAL_ARCH_CLASS a

join mysql.help_topic b on b.help_topic_id < (length(a.value_item) - length(replace(a.value_item,';',''))+1)

order by a.id;

12.20 内置函数

1. 空间查询 st_distance_sphere

效率高

SELECT st_distance_sphere(POINT(117.2649120808,31.9344120986),point(117.2594242812,31.9364424285))

自定义函数-空间计算

CREATE DEFINER=`root`@`%` FUNCTION `F_DISTANCE`(`cx` double,`cy` double,`sx` double,`sy` double) RETURNS double

begin

DECLARE d FLOAT(10,2);

DECLARE x FLOAT(10,2);

DECLARE y FLOAT(10,2);

DECLARE r FLOAT(10,2);

DECLARE pi FLOAT(10,2);

set r=6371229;

set pi=3.14159265358979323;

set x=(sx-cx)*pi*r*cos((sy+cy)/2*pi/180)/180;

set y=(sy-cy)*pi*r/180;

set d=SQRT(power(x,2)+power(y,2));

set D=ROUND(D,2);

RETURN d;

end

2. GREATEST()函数返回输入参数最大值

-- 查询'zt_time' , 'zy_time' , 'zn_time'中最大一个

SELECT

GREATEST(zt_time, zy_time, zn_time)

FROM

'XXX'

limit 取前多少条数据

select * from dw.dwd_sdxs_job_op limit 100;

空间函数,计算 坐标距离 (米)

计算地球两点之间的球面距离,单位为 米。传入的参数分别为X点的经度,X点的纬度,Y点的经度,Y点的纬度。

select st_distance_sphere(point(116.35620117,39.939093), point(116.4274406433,39.9020987219));

截取 substring 和 instr

select substring(hour_part,1,instr(hour_part,':')-1),hour_part from dw.dwd_sdxs_user_rec_hour h where to_days(data_dt)=to_days(now())

| hour | hour_part |

|---|---|

| 9 | 9:00-10:00 |

| 10 | 10:00-11:00 |

保留小数

select round(12.34345,2) -- 12.34

判断是否存在自定字符

case when LOCATE('±',l.volt_name)>0 then REPLACE(l.volt_name,'±','交流') else concat('直流',l.volt_name) end,

GREATEST()函数查找给定数字之间的最大数字。

SELECT GREATEST(10, 20, 30, 40, 50)

least 函数查找给定数字之间的最小数字。

SELECT least(10, 20, 30, 40, 50)

COALESCE

按照参数的顺序逐个评估参数,并返回第一个非空值

- 用途:

1)将控制替换成其他值;

2)返回第一个非空值

表达式

COALESCE是一个函数, (expression_1, expression_2, ...,expression_n)依次参考各参数表达式,遇到非null值即停止并返回该值。如果所有的表达式都是空值,最终将返回一个空值。使用COALESCE在于大部分包含空值的表达式最终将返回空值。

SQL实例

select coalesce(success_cnt, 1) from tableA

-- 以上写法将会判断certificate_file和labor_file字段是否为空,如果其中任意一个字段非空,则返回1,否则返回0。

SELECT CASE WHEN COALESCE(certificate_file, labor_file) IS NOT NULL THEN 1 ELSE 0 END as idPermitApply, a.* FROM zjjc_person a;

COALESCE()函数可以用来完成几乎所有的空值处理,不过在很多数据库系统中都提供了它的简化版,这些简化版中只接受两个变量,其参数格式如下: MYSQL: IFNULL(expression,value) MSSQLServer: ISNULL(expression,value) Oracle: NVL(expression,value)

这几个函数的功能和COALESCE(expression,value)是等价的。

比如SQL语句用于返回人员的“重要日期”,如果出生日期不为空则将出生日期做为“重要日期”,如果出生日期为空则返回注册日期的值:

-- MYSQL:

SELECT FBirthDay,FRegDay, IFNULL(FBirthDay,FRegDay) AS ImportDay FROM T_Person

-- MSSQLServer

SELECT FBirthDay,FRegDay, ISNULL(FBirthDay,FRegDay) AS ImportDay ROM T_Person

-- Oracle

SELECT FBirthDay,FRegDay, NVL(FBirthDay,FRegDay) AS ImportDay ROM T_Person

12.30 创建函数

set global log_bin_trust_function_creators=1;

如果创建的是带参 函数,需要给参数指定 类型同时指定大小,否则会报下面的错误

1064 - You have an error in your SQL syntax; check the manual that corresponds to your MySQL server version for the right syntax to use near ')

CREATE DEFINER = CURRENT_USER FUNCTION `simpleFun`(name VARCHAR(20))

RETURNS varchar(30)

BEGIN

#Routine body goes here...

RETURN name;

END;

声明参数

drop function if exists hello;

-- a、b 都是函数的参数

create function hello(a varchar(20),b varchar(20)) returns varchar (255)

begin

-- declare 声明参数,default:设置声明参数的默认值

declare x varchar(255) default ' x ';

declare y varchar(255) default b;

declare c varchar(255) default ' 2017-01-02 ';

declare d varchar(255);

-- set 给声明的参数赋值

SET d = concat(x,a,b,y,c);

return d;

end;

12.40 定义变量

# 定义变量

set @dt = now();

select date_add(@dt, interval 1 day); -- add 1 day

select date_add(@dt, interval 1 hour); -- add 1 hour

# 赋值

set @:= 1;

select @dt:= @dt+3;

SELECT @dt:=5;

12.50 with as (创建临时表)

如果查询 报没有登陆数据库,可以通过 use DATABASES; 相当于先登陆一个数据库,创建的临时表就在 这个数据库下

with ydxj_ttsh_temp as -- ydxj_ttsh_temp 相当于一张临时表

(select t.line1_tower_id

from sdt_xjb.ydxj_ttsh t

)

select * from ydxj_ttsh_temp;

- 需要定义多个 临时表,可有用逗号相连, with xx as () , yy as ()

with temp1 as -- ydxj_ttsh_temp 相当于一张临时表

(select t.line1_tower_id

from table_name1 t

), temp2 as (